Способ адаптивной автоматической самонастройки многопараметрических систем автоматического управления на оптимальные условия

Иллюстрации

Показать всеИзобретение относится к автоматической оптимизации многопараметрических объектов управления, обладающих одноэкстремальной функцией качества, основанной на каком-либо критерии оптимальности. Технический результат заключается в повышении быстродействия поиска. Способ состоит в том, что в пространстве оптимизируемых параметров из исходного состояния делают шаг в случайном направлении в соответствии с нормальным законом распределения и в зависимости от значения функции качества в новом состоянии либо возвращают систему в первоначальное состояние и формируют случайный шаг, отсчитанный из старого состояния, либо за исходное состояние берут новое и формируют случайный шаг, отсчитанный из нового исходного состояния. Адаптация распределения направления случайных шагов заключается в изменении их математического ожидания на основе знака приращения функции качества, а адаптацию интенсивности самообучения осуществляют на основе величины текущего шага поиска, т.е. коэффициент запоминания рассчитывают как отношение числа неудачных проб к общему количеству проб, параметр скорости обучения рассчитывают как отношение числа удачных проб к общему количеству проб, проведенных до текущего момента оптимизации. 1 ил., 2 табл.

Реферат

Изобретение относится к автоматической оптимизации многопараметрических объектов управления, обладающих одноэкстремальной функцией качества, основанной на каком-либо критерии оптимальности.

Известны способы случайного поиска экстремума функции качества одноэкстремальных многопараметрических объектов, заключающиеся в формировании случайных входных шаговых воздействий на объект управления [1].

Недостатком таких способов является невысокое быстродействие поиска на объектах управления. Наиболее близким к изобретению по технической сущности является способ, основанный на формировании случайных нормально распределенных входных шаговых воздействий на объект управления и адаптации их распределения и интенсивности самообучения [2].

Недостатком этого способа является невысокое быстродействие поиска. Увеличение быстродействия поиска достигается при адаптации интенсивности самообучения на основе величины текущего шага поиска.

Предлагаемый способ заключается в том, что создают режим адаптивного случайного поиска в пространстве оптимизируемых параметров, основанный на формировании случайных входных шаговых воздействий на объект управления, распределенных по нормальному закону, математическое ожидание которых автоматически адаптируют в зависимости от сигнала, поступающего с выхода объекта по каналу обратной связи, а адаптацию интенсивности самообучения в процессе поиска осуществляют на основе величины текущего шага поиска, т.е. коэффициент запоминания рассчитывают как отношение числа неудачных проб к общему количеству проб, проведенных до текущего момента оптимизации, параметр скорости обучения рассчитывают как отношение числа удачных проб к общему количеству проб, проведенных до текущего момента оптимизации.

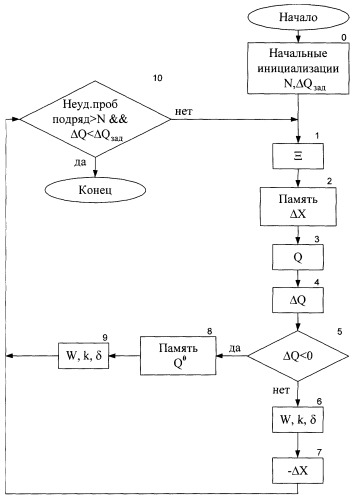

На чертеже представлена блок-схема алгоритма, реализующего предлагаемый способ автоматической настройки многопараметрических систем автоматического управления на оптимальные условия (для определенности представлен случай минимизации функции качества).

Блок-схема включает в себя: 0 - блок начальных инициализаций, 1 - блок формирования шага в случайном направлении в пространстве оптимизируемых параметров в соответствии с нормальным законом распределения, 2 - блок запоминания сформированного шага, 3 - блок определения значения функции качества в новой точке пространства оптимизируемых параметров, 4 - блок определения знака приращения функции качества, 5 - блок условия для удачного шага, 8 - блок запоминания значения функции качества при удачном шаге, 6 и 9 - блоки адаптации распределения направления поисковых шагов и интенсивности самообучения в процессе настройки, 7 - блок формирования шага в обратном направлении при неудачном шаге, 10 - блок условий для окончания оптимизации.

Предлагаемый способ реализуют следующим образом. В пространстве оптимизируемых параметров из исходного состояния Хi делают шаг в случайном направлении в соответствии с нормальным законом распределения (блоки 1, 2, 3, 4).

Если значение функции качества в новом состоянии Q(Xi+1) больше или равно значению функции качества в исходной точке Q(Xi), то есть случайная проба Ξн оказалась неудачной (задача минимизации), то система возвращается в первоначальное состояние Xi, после чего снова формируют случайный шаг, отсчитанный из старого состояния.

Если значение функции качества в новом состоянии Q(Xi+1) меньше значения функции качества в исходной точке Q(Xi), то есть случайная проба Ξн оказалась удачной (задача минимизации), то за исходное состояние берется новое Q(Xi+1), после чего снова формируют случайный шаг, отсчитанный из нового исходного состояния.

Рекуррентное выражение для поискового алгоритма с нормально распределенными случайными пробами принимает вид:

где Q0 i=minQ(Xj), j=1,...,i - наименьшее значение функции качества за i предыдущих шагов поиска,

Ξн - единичный случайный вектор, распределенный по нормальному закону,

a - величина рабочего шага.

Алгоритм адаптации среднего квадратического отклонения направления нормально распределенных случайных шагов можно представить в виде следующего выражения:

где σI - текущая величина среднего квадратического отклонения;

σmin и σmax - минимальное и максимальное значения среднего квадратического отклонения.

Адаптация распределения направления случайных шагов заключается в изменении их математического ожидания на основе знака приращения функции качества (блоки 6 и 9 на чертеже). Алгоритм непрерывной адаптации математического ожидания случайных шагов можно представить в виде следующего векторного рекуррентного соотношения:

Wi+1=kWi-δΔQiΔXi,

где W - математическое ожидание равномерно распределенных случайных шагов,

k - коэффициент запоминания (0≤k≤1),

δ - параметр скорости обучения (0≤δ≤1).

Коэффициенты k и δ определяют интенсивность самообучения в процессе поиска.

При работе по этому алгоритму адаптации вектор W стремится перестроиться в направлении, обратном градиенту функции качества оптимизируемого объекта, то есть шаги поиска будут в среднем направлены в сторону быстрейшего уменьшения функции качества.

Адаптация интенсивности самообучения в процессе оптимизации на основе величины текущего шага (блоки 6 и 9 на фиг.) осуществляется с помощью следующих выражений для коэффициентов k и δ:

т.е.

где kуд и kнеуд - число удачных и неудачных проб, проведенных до текущего момента оптимизации.

Смысл этого алгоритма адаптации интенсивности самообучения заключается в следующем. Если в процессе поиска растет число удачных шагов kуд, а число неудачных шагов kнеуд уменьшается, т.е. функция качества ΔQ(X) движется к экстремуму, то величина рабочего шага α увеличивается, скорость обучения δ также растет, т.е. происходит интенсивное обучение на основе нового опыта, в то время как коэффициент запоминания k уменьшается, т.е. нет необходимости запоминать весь предыдущий накопленный опыт.

Если же в процессе поиска число удачных шагов kуд уменьшается, а число неудачных шагов kнеуд увеличивается, т.е. функция качества ΔQ(X) все ближе подходит к экстремуму, то величина рабочего шага α уменьшается, скорость обучения δ уменьшается, т.е. нет необходимости интенсивно обучаться, а коэффициент запоминания k увеличивается, т.е. запоминается весь предыдущий накопленный опыт.

| Таблица 1 | |||

| Модель | Среднее время поиска, шагов поиска | Выигрыш в быстродействии, процентов | |

| Прототип | Усовершенствованная адаптация k и δ | ||

| Полиномиальная | 274 | 258 | 5,84 |

| Центральная | 274 | 258 | 5,84 |

| Квадратичная | 303 | 287 | 5,28 |

| Функция Пауэла | 2357 | 2144 | 9,04 |

| Погрешность ΔQмин=0,1 |

| Таблица 2 | |||

| Модель | Среднее время поиска, шагов поиска | Выигрыш в быстродействии, процентов | |

| Прототип | Усовершенствованная адаптация k и δ | ||

| Полиномиальная | 569 | 532 | 6,50 |

| Центральная | 569 | 533 | 6,33 |

| Квадратичная | 652 | 614 | 5,83 |

| Функция Пауэла | 6654 | 6140 | 7,72 |

| Погрешность ΔQмин=0,01 |

Полиномиальная модель:

Q(X)=x1+x1 2+x2+x2 2+x3+x3 2+x4+x4 2+1

Центральная модель:

Квадратичная модель:

где [А, Х] - скалярное произведение вектора параметрических коэффициентов А=(а1, а2, а3, а4)Т и вектора входных координат Х=(x1,x2,x3,x4)т, ai=1, i=1...4, bij - элементы матрицы:

Функция Пауэла:

Q(X)=(x1+10x2)2+5(x3-x4)4+(x2-2x3)4+10(x1-x4)4.

Функция Пауэла моделирует объект оптимизации с ярко выраженной овражностью функции качества.

Этот способ обладает универсальностью применения, что позволяет использовать его независимо от вида функции качества. Причем, если имеются определенные априорные данные о структуре функции качества, то не обязательно использовать всю информацию о неудачных и удачных пробах, а можно ограничиться данными за последние N шагов оптимизации. Однако N не должно быть слишком малым, иначе точность отыскания экстремума будет недостаточно высокой. Эксперименты на модельных функциях показали, что для большинства случаев оптимальным является N=100. Это достаточно для высокой мобильности алгоритма адаптации шага и отыскания экстремума с высокой точностью.

При проведении сравнительного тестирования использовался одинаковый для всех моделей набор из 100 начальных точек поиска, координаты которых представляли собой случайные равномерно распределенные числа в пределах от минус 10 до плюс 10. Цикл поиска экстремума для каждой начальной точки повторялся 100 раз.

Из таблиц видно что максимальный выигрыш в производительности имел место при оптимизации модельного объекта, обладающего функцией качества с ярко выраженной овражностью (Функция Пауэла). Поскольку реальные объекты автоматического управления очень часто имеют овражные функции качества, то применение предлагаемого метода оказывается целесообразным для их эффективной оптимизации.

Достигаемый технический эффект от применения предлагаемого способа позволяет уменьшить потери на поиск и повысить быстродействие отыскания экстремума функций качества объектов оптимизации: экспериментальные исследования, проведенные на модельных функциях, показали, что выигрыш в быстродействии предлагаемого способа по сравнению с прототипом составил от 5 до 9 процентов в зависимости от вида модельной функции и точности нахождения экстремума (см. таблицы).

СПИСОК ЛИТЕРАТУРЫ

1. Растригин Л.А. Системы экстремального управления. М.: Наука, 1974, с.422-446.

2. Щедринов А.В., Кравченко А.Ю. Адаптивный случайный поиск // Приборы и системы. Управление, контроль, диагностика. - 2001. - №6. - С.39-42 (прототип).

Способ адаптивной автоматической самонастройки многопараметрических систем автоматического управления на оптимальные условия путем создания режима адаптивного случайного поиска в пространстве оптимизируемых параметров, основанный на формировании случайных входных шаговых воздействий на объект управления, математическое ожидание которых автоматически адаптируют в зависимости от сигнала, поступающего с выхода объекта по каналу обратной связи в соответствии с соотношением Wi+1=kWi-δΔQiΔXi, где W - математическое ожидание равномерно распределенных случайных шагов, k - коэффициент запоминания, δ - параметр скорости самообучения, Q - функция качества, Х - состояние объекта в пространстве оптимизируемых параметров, величину случайных входных шаговых воздействий адаптируют в соответствии с соотношением

где kуд и kнеуд - число удачных и неудачных проб, проведенных до текущего момента оптимизации, отличающийся тем, что адаптацию интенсивности самообучения в процессе поиска осуществляют на основе величины текущего шага поиска, т.е. коэффициент запоминания рассчитывают как отношение числа неудачных проб к общему количеству проб, проведенных до текущего момента оптимизации, параметр скорости обучения рассчитывают как отношение числа удачных проб к общему количеству проб, проведенных до текущего момента оптимизации, в соответствии с выражениями