Способ генерации предсказанной опорной информации, способы кодирования и декодирования видео, устройства для этого, программы для этого и носитель данных, хранящий эти программы

Иллюстрации

Показать всеИзобретение относится к способу кодирования многовидового видео с использованием способа генерации предсказанной опорной информации. Техническим результатом является повышение эффективности кодирования информации для межкадрового предсказания. Предложено видеоизображения обрабатывать путем применения к каждой разделенной области операций кодирования с межкадровым предсказанием по времени или по пространству и генерации предсказанного изображения обрабатываемой целевой области на основании опорного кадра обрабатываемой целевой области и опорной информации, которая указывает предсказанную целевую позицию обрабатываемой целевой области в опорном кадре, предсказанная опорная информация генерируется как предсказанная информация опорной информации. Опорная информация, использованная при обработке целевой области, смежной с обрабатываемой целевой областью, определяется как данные предсказания предсказанной опорной информации, используемые при предсказании опорной информации обрабатываемой целевой области. Опорная информация опорной области генерируется, используя один или более частей опорной информации, использованной при обработке опорной области, указанной данными предсказания. Данные предсказания предсказанной опорной информации обновляются, используя опорную информацию опорной области. Предсказанная опорная информация генерируется, используя один или более частей данных предсказания обновленной предсказанной опорной информации. 9 н. и 16 з.п. ф-лы, 29 ил.

Реферат

Область техники

Настоящее изобретение относится к способу генерации предсказанной опорной информации и к соответствующему устройству, которые применяются, когда (i) обрабатывают видеоизображение путем разделения изображения на отдельные области; применяют к каждой области разделенного изображения кодирование с временным или пространственным межкадровым предсказанием; и генерируют предсказанное изображение обрабатываемой целевой области на основании опорного кадра обрабатываемой целевой области и опорную информацию, которая указывает предсказанное целевое положение обрабатываемой целевой области в опорном кадре; и (ii) генерируют предсказанную опорную информацию в качестве предсказанной информации соответствующей опорной информации. Настоящее изобретение также относится к способу кодирования видео с использованием способа генерации предсказанной опорной информации и соответствующего устройства; устройству декодирования видео для декодирования кодированных данных, сгенерированных посредством способа кодирования видео и соответствующего устройства; программе генерации предсказанной опорной информации для реализации способа генерации предсказанной опорной информации и компьютерно-читаемому носителю, который хранит эту программу; программе кодирования для реализации способа кодирования видео и компьютерно-читаемому носителю, который хранит эту программу; и к программе декодирования видео для реализации способа декодирования видео и компьютерно-читаемому носителю, который хранит эту программу.

Настоящая заявка притязает на приоритет японской патентной заявки № 2006-293929, поданной 30 октября 2006 г., содержимое которой включено в настоящий документ посредством ссылки.

Уровень техники

Многоперспективные видеоизображения представляют собой множество видеоизображений, которые получают путем снятия одного и того же объекта и его фона посредством множества камер. В настоящем документе видеоизображение, полученное посредством одной камеры, обозначается термином "двумерное видеоизображение", а набор из множества двумерных видеоизображений, полученных путем снятия одного и того же объекта и его фона, обозначается термином "многоперспективное видеоизображение".

Существует строгая временная корреляция между двумерными видеоизображениями каждой камеры, которые включаются в состав многоперспективного видеоизображения. В добавление, когда камеры синхронизированы друг с другом, изображения (снимаемые камерами), соответствующие одному и тому же моменту времени, захватывают объект и его фон как одно целое с различных позиций, так что между камерами есть строгая корреляция. Посредством этой корреляции эффективность кодирования видео может быть повышена.

Ниже следует иллюстрация обычных способов кодирования двумерных видеоизображений.

Во многих способах кодирования двумерных видеоизображений, таких как MPEG-2 и H.264 (которые являются международными стандартами кодирования видео) и т.п., высокая эффективность кодирования достигается посредством кодирования с межкадровым предсказанием, в котором используется временная корреляция.

Кодирование с межкадровым предсказанием, выполняемое для кодирования двумерных видеоизображений, использует временную вариацию видеоизображения, то есть движение. Соответственно, способ, используемый в кодировании с межкадровым предсказанием, обычно называют "компенсацией движения". Так, кодирование с межкадровым предсказанием вдоль временной оси называется "компенсация движения". В добавление, "кадр" представляет собой изображение, которое образует часть видеоизображения и получается в определенный момент времени.

Обычно, кодирование двумерного видеоизображения имеет два режима кодирования для каждого кадра: "I-кадр" кодируется без использования межкадровой корреляции, "P-кадр" кодируется с выполнением компенсации движения на основе одного уже кодированного кадра, а "B-кадр" кодируется с выполнением компенсации движения на основе двух уже кодированных кадров.

Для дополнительного улучшения эффективности предсказания в стандартах H.263 и H.264 декодированные изображения множества кадров (то есть двух или более кадров) сохраняются в памяти опорных изображений, и для выполнения предсказания из этой памяти выбирается одно опорное изображение.

Опорное изображение может быть выбрано для каждого блока, и информация описания опорного изображения, описывающая это опорное изображение, может быть закодирована для выполнения соответствующего декодирования.

При компенсации движения, в добавление к информации описания опорного изображения, также кодируется вектор для индикации позиции в опорном изображении, причем целевой блок кодируется, используя эту позицию, и вектор называется "вектором движения".

При кодировании вектора движения в стандарте MPEG-4 или H.264 генерируется предсказанный вектор, используя вектор движения блока, смежного с кодируемым целевым блоком, и при компенсации движения, прилагаемой к целевому блоку, используется только дифференциальный вектор между предсказанным вектором и вектором движения. Согласно этому способу, когда между соответствующими смежными блоками присутствует непрерывность движения, вектор движения может быть закодирован с высокой степенью эффективности кодирования.

В непатентном документе 1 раскрыт подробный процесс генерации предсказанного вектора согласно стандарту H.264. Ниже представлено обобщенное описание этого процесса.

Как показано на Фиг.20A, в стандарте H.264 на основании векторов (mv_a, mv_b и mv_c) движения, используемых в левом блоке (см. "a" на Фиг.20A), верхнем блоке (см. "b" на Фиг.20A) и правом верхнем блоке (см. "c" на Фиг.20A) относительно целевого блока, горизонтальные и вертикальные компоненты получаются путем вычисления медианы для каждого направления.

Поскольку в стандарте H.264 применяется компенсация движения с переменным размером блока, размер блока для компенсации движения может быть разным для кодируемого целевого блока и блоков, расположенных по его периферии. В таком случае, как показано на Фиг.20B, в качестве блока "a" выбирается самый верхний блок из блоков, примыкающих к целевому блоку с левой стороны, в качестве блока "b" устанавливается самый левый блок из блоков, примыкающих к целевому блоку с верхней стороны, а в качестве блока "c" выбирается самый ближний верхний левый блок.

Как исключение, если размер целевого блока составляет 8×16 пикселей, как показано на Фиг.20C, то вместо медианы для выполнения предсказания используется блок "a" и блок "c" соответственно для левой стороны и правой стороны. Аналогично, если размер целевого блока составляет 16×8 пикселей, как показано на Фиг.20D, то вместо медианы для выполнения предсказания используется блок "a" и блок "b" соответственно для нижней стороны и верхней стороны.

Как описано выше, в стандарте H.264 для каждого блока опорный кадр выбирается из множества уже кодированных кадров и используется для компенсации движения.

Обычно, движение объекта изображения неравномерно и зависит от опорного кадра. Следовательно, по сравнению с вектором движения в компенсации движения с использованием опорного кадра, отличного от опорного кадра кодируемого целевого блока, вектор движения в компенсации движения с использованием опорного кадра, совпадающего с опорным кадром целевого блока, должен быть ближе к вектору движения, используемому для целевого блока.

Следовательно, согласно стандарту H.264, если присутствует только один блок (из блоков a, b и c), опорный кадр которого совпадает с опорным кадром кодируемого целевого блока, то вместо медианы в качестве предсказанного вектора используется вектор движения соответствующего блока, чтобы генерировать предсказанный вектор с относительно более высоким уровнем надежности.

Для случая когда во множестве кадров присутствует непрерывность движения, например, когда объект выполняет равномерное линейное движение, известен способ кодирования вектора движения с высокой эффективностью, в котором вектор движения непосредственно предшествующего кадра в порядке кодирования накапливается, и информация вектора движения подвергается масштабированию согласно соответствующему временному интервалу, чтобы вычислить вектор движения.

Для детектирования временного интервала в качестве информации используется время выхода каждого кадра.

Обычно, подобная информация времени кодируется для каждого кадра, поскольку информация времени необходима, когда, например, порядок ввода и порядок кодирования заданных изображений отличаются друг от друга, и изображения декодируются в порядке времени формирования изображений. То есть на стороне кодера каждый кадр кодируется, устанавливая информацию времени, назначенную каждому введенному изображению, согласно порядку ввода, а на стороне декодера декодированное изображение каждого кадра выводится в порядке согласно установленной информации времени.

Согласно стандарту H.264 так называемый "временной прямой режим" представляет собой способ кодирования вектора движения с высоким уровнем эффективности кодирования, используя непрерывность движения по множеству кадров.

Например, для кадров A, B и C, показанных на Фиг.21, предполагается, что кадры A, C и B последовательно кодируются в этом порядке и кадр C кодируется с использованием кадра A в качестве опорного кадра, чтобы выполнить компенсацию движения. В таком состоянии во временном прямом режиме вычисляется вектор движения блока в кадре B, как описано ниже.

Сначала детектируется вектор mv движения, который используется на блоке, принадлежащем кадру C, и который находится в той же позиции, что и кодируемый целевой блок.

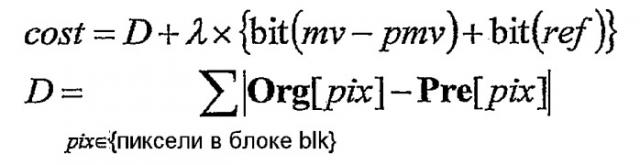

Далее, согласно нижеприведенным формулам вычисляется вектор fmv движения, когда в качестве опорного рассматривается кадр A, а также вектор bmv движения, когда в качестве опорного рассматривается кадр C.

fmv = (mv×TAB)/TAC,

bmv = (mv×TBC)/TBC,

где TAB, TBC и TAC представляют собой соответственно временной интервал между кадрами A и B, временной интервал между кадрами B и C и временной интервал между кадрами A и C.

Согласно стандарту H.264 временной прямой режим может использоваться только для "B-кадра" (кадра с предсказанием в двух направлениях), который использует два опорных кадра для каждого блока.

В непатентном документе 2 описано применение вышеупомянутого режима таким образом, что эффективное кодирование вектора движения может быть реализовано также в P-кадре, который использует только один опорный кадр для каждого блока.

Кроме того, в непатентном документе 3 раскрыт способ эффективного кодирования вектора движения при условии непрерывности движения между смежными блоками и непрерывности движения по множеству кадров.

Фиг.22A-22D иллюстрируют общую концепцию этого способа. В этом способе, подобно стандартам H.264 и MPEG-4, предсказанный вектор генерируется, используя вектор движения периферийного блока, расположенного рядом с кодируемым целевым блоком, и кодируется только дифференциальный вектор между предсказанным вектором и вектором движения, который используется в фактической компенсации движения (см. Фиг.22A).

В отличие от стандарта H.264 и т.п. вектор движения периферийного блока не используется напрямую, а вместо этого он используется после масштабирования согласно соответствующему временному интервалу посредством следующей формулы.

mv_k' = mv_k × Tct/Tck,

где mv_k представляет собой исходный вектор движения, mv_k' представляет собой вектор движения после масштабирования, Tct - это временной интервал между кодируемым целевым кадром и кадром, на который должен ссылаться кодируемый целевой блок, а Tck - это временной интервал между кодируемым целевым кадром и кадром, на который ссылается периферийный блок целевого блока (см. Фиг.22B-22D).

Ниже описаны обычные способы кодирования многоперспективных видеоизображений.

Обычно, при кодировании многоперспективного видео используется корреляция между камерами, и высокий уровень эффективности кодирования обеспечивается путем использования "компенсации расхождения", при которой компенсация движения применяется к кадрам, которые сняты в одно время посредством разных камер.

Например, подобный способ используется в профиле MPEG-2 Multiview, а также в непатентном документе 4.

В способе, раскрытом в непатентном документе 4, для каждого блока выбирается какой-либо один тип компенсации - либо компенсация движения, либо компенсация расхождения. То есть для каждого блока выбирается компенсация с более высокой эффективностью кодирования, чтобы можно было использовать как временную корреляцию, так и корреляцию между камерами. По сравнению со случаем применения только одного типа корреляции, в этом случае обеспечивается более высокая эффективность кодирования.

В компенсации расхождения в добавление к остатку предсказания также кодируется вектор расхождения. Вектор расхождения соответствует вектору движения для индикации временной вариации между кадрами, и он указывает разность между позициями на плоскостях изображения, которые получаются камерами, установленными в разных позициях, и на которые проектируется одно положение снимаемого объекта.

Фиг.23 представляет собой схематический вид, иллюстрирующий расхождение, генерируемое между такими камерами. В схематическом виде с Фиг.23 плоскости изображения камер, оптические оси которых параллельны друг другу, показаны сверху.

При кодировании вектора расхождения, подобно кодированию вектора движения, представляется возможным, что предсказанный вектор генерируется с использованием вектора расхождения блока, расположенного рядом с кодируемым целевым блоком, и кодируется только дифференциальный вектор между предсказанным вектором и вектором расхождения, используемый в компенсации расхождения, которое применяется к целевому блоку. Согласно такому способу, когда между соответствующими смежными блоками присутствует непрерывность расхождения, вектор расхождения может быть кодирован с высокой степенью эффективности кодирования.

Непатентный документ 1: ITU-T Rec.H.264/ISO/IEC 11496-10, "Editor's Proposed Draft Text Modifications for Joint Video Specification (ITU-T Rec. H.264/ISO/IEC 14496-10 AVC), Draft 7", Final Committee Draft, Document JVT-E022, p. 63-64 and 117-121, September, 2002.

Непатентный документ 2: Alexis Michael Tourapis, "Direct Prediction for Predictive (P) and Bidirectionally Predictive (B) frames in Video Coding," JVT-C128, Joint Video Team (JVT) of ISO/IEC MPEG&ITU-T VCEG Meeting, p. 1-11, May, 2002.

Непатентный документ 3: Sadaatsu Kato and Choong Seng Boon, "Motion Vector Prediction for Multiple Reference Frame Video Coding Using Temporal Motion Vector Normalization", PCSJ2004, Proceedings of the 19th Picture Coding Symposium of Japan, P-2.18, Nov., 2004.

Непатентный документ 4: Hideaki Kimata and Masaki Kitahara, "Preliminary results on multiple view video coding (3DAV)", document M10976 MPEG Redmond Meeting, July, 2004.

Раскрытие изобретения

Проблемы, решаемые с помощью изобретения

Обычные способы, в которых вектор движения или вектор расхождения, по существу, используемый при кодировании целевого блока, кодируется, используя различие от предсказанного вектора, сгенерированного посредством вектора движения или вектора расхождения, используемого в смежном блоке, основаны на том факте, что снятое изображение непрерывно в вещественном пространстве и что есть высокая вероятность того, что само движение снятого объекта значительно не меняется. Следовательно, вектор движения или вектор расхождения, используемые в целевом блоке, могут быть кодированы посредством меньшего объема кода.

Тем не менее, если опорный кадр, который является наиболее подходящим для предсказания изображения целевого блока, не используется в соответствующем смежном блоке, разность между предсказанным вектором и фактически использованным вектором движения увеличивается, и объем кода невозможно значительно уменьшить.

В частности, при выполнении кодирования путем адаптивного выбора компенсации движения или компенсации расхождения для каждого блока невозможно сгенерировать предсказанный вектор вектора расхождения из вектора движения, или сгенерировать предсказанный вектор вектора движения из вектора расхождения, поскольку вектор движения и вектор расхождения имеют значительно отличающиеся характеристики. Следовательно, представляется невозможным эффективно кодировать информацию для межкадрового предсказания.

Для вектора движения, даже когда опорный вектор не используется в смежном блоке на момент, который является наиболее подходящим для предсказания изображения кодируемого целевого блока, эффективный вектор движения может быть сгенерирован путем использования временного прямого режима, раскрытого в непатентном документе 1, либо способа, раскрытого в непатентном документе 2 или непатентном документе 3.

Тем не менее, в таких способах предполагается наличие непрерывности движения по кадрам. Следовательно, если снятый объект не демонстрирует движения, близкого по форме к линейному равномерному движению по нескольким кадрам, будет невозможно сгенерировать эффективный предсказанный вектор.

Кроме того, для вектора расхождения, если опорный кадр, снятый камерой, которая является наиболее подходящей для предсказания изображения кодируемого целевого блока, не используется для смежного блока, эффективный вектор расхождения может быть сгенерирован по способу, который может быть легко выведен по аналогии и в котором вектор расхождения, используемый в смежном блоке, подвергается масштабированию, используя интервал между соответствующими камерами вместо временного интервала.

В таком способе, хотя подходящий предсказанный вектор может быть сгенерирован, когда направления камер параллельны (то есть имеют параллельные оптические оси), в иных условиях генерация подходящего предсказанного вектора будет невозможна.

Само собой разумеется, что даже когда применяется такой способ, в котором используется уже кодированный вектор движения или вектор расхождения, полученный путем масштабирования с помощью временного интервала или интервала между камерами, представляется сложным генерировать подходящий предсказанный вектор, если для каждого блока адаптивно выбирается либо компенсация движения, либо компенсация расхождения. Соответственно, эффективное кодирование невозможно реализовать.

В свете вышеизложенных обстоятельств целью настоящего изобретения является предоставление нового способа для генерации предсказанного вектора или предсказанной информации расхождения, которая значительно не отличается от предсказанного вектора или информации расхождения, использованной при предсказании изображения во время кодирования, даже когда фактическое или видимое движение снятого объекта или камеры не является линейным равномерным движением по множеству кадров.

Средство для решения проблемы

(1) Устройство генерации предсказанной опорной информации настоящего изобретения

Для достижения вышеупомянутой цели устройство генерации предсказанной опорной информации согласно настоящему изобретению обрабатывает видеоизображение путем разделения изображения на области; применения к каждой области разделенного изображения кодирования с временным или пространственным межкадровым предсказанием; и генерации предсказанного изображения обрабатываемой целевой области на основании опорного кадра обрабатываемой целевой области и опорной информации, которая указывает предсказанное целевое положение обрабатываемой целевой области в опорном кадре; и генерирует предсказанную опорную информацию в качестве предсказанной информации соответствующей опорной информации. Устройство генерации предсказанной опорной информации включает в себя:

(a) блок установки данных предсказания предсказанной опорной информации для установки опорной информации, которая была использована при обработке области, смежной с обрабатываемой целевой областью, в качестве данных предсказания предсказанной опорной информации, используемых для предсказания опорной информации обрабатываемой целевой области;

(b) блок генерации опорной информации опорной области для генерации опорной информации опорной области на основании одного или более кусков опорной информации, использованной при обработке опорной области, указанной данными предсказания предсказанной опорной информации;

(c) блок обновления данных предсказания предсказанной опорной информации для обновления данных предсказания предсказанной опорной информации путем использования сгенерированной опорной информации опорной области; и

(d) блок генерации предсказанной опорной информации для генерации предсказанной опорной информации путем использования одного или более кусков данных предсказания обновленной предсказанной опорной информации.

Вышеупомянутые блоки также могут быть реализованы посредством компьютерной программы. Такая компьютерная программа может быть предоставлена путем ее сохранения на подходящем компьютерно-читаемом носителе, либо посредством сети, и она может быть инсталлирована и приведена в действие на устройстве управления, таком как CPU, чтобы реализовать настоящее изобретение.

В устройстве генерации предсказанной опорной информации с вышеупомянутой структурой сначала опорная информация, которая была использована при обработке области, смежной с обрабатываемой целевой областью, устанавливается в качестве данных предсказания предсказанной опорной информации, используемых для предсказания опорной информации обрабатываемой целевой области.

Далее, опорная информация опорной области генерируется на основании одного или более кусков опорной информации, использованной при обработке опорной области, указанной данными предсказания предсказанной опорной информации, и установленные данные предсказания предсказанной опорной информации обновляются путем использования сгенерированной опорной информации опорной области.

Далее, предсказанная опорная информация генерируется как предсказанная информация опорной информации для обрабатываемой целевой области путем использования одного или более кусков обновленных данных предсказания предсказанной информации.

Следовательно, в устройстве генерации предсказанной опорной информации согласно настоящему изобретению предсказанная опорная информация как предсказанная информация опорной информации для обрабатываемой целевой области не генерируется путем прямого применения опорной информации, использованной, когда была обработана смежная область обрабатываемой целевой области. Вместо этого, принимая во внимание нелинейное движение снятого объекта или неравномерное движение камеры, соответствующая обработка включает в себя установку опорной информации, использованной, когда была обработана смежная область обрабатываемой целевой области; генерацию опорной информации опорной области на основании одного или более кусков опорной информации, использованной при обработке опорной области, указанной данными предсказания предсказанной опорной информации; обновление данных предсказания предсказанной опорной информации путем использования сгенерированной опорной информации опорной области; и генерацию предсказанной опорной информации в качестве предсказанной информации опорной информации для обрабатываемой целевой области путем использования данных предсказания обновленной предсказанной опорной информации.

В упомянутой обработке процесс обновления данных предсказания предсказанной опорной информации может повторяться с использованием данных предсказания обновленной предсказанной опорной информации. В таком случае соответствующий процесс может повторяться до тех пор, пока не будет получен опорный кадр обрабатываемого целевого кадра.

В устройстве генерации предсказанной опорной информации согласно настоящему изобретению, даже когда нет какой-либо временной непрерывности вариации видеоизображения по множеству кадров или когда многоперспективное изображение кодируется или декодируется с выбором компенсации движения либо компенсации расхождения для каждой обрабатываемой целевой области, разность между предсказанной опорной информацией и опорной информацией, использованной при кодировании или декодировании обрабатываемой целевой области может быть уменьшена, таким образом, обеспечивая эффективное кодирование или декодирование вектора движения или информации расхождения, используемой при кодировании с межкадровым предсказанием.

(2) Способ кодирования видео настоящего изобретения

Способ генерации предсказанной опорной информации настоящего изобретения, который может быть реализован посредством вышеупомянутого устройства генерации предсказанной опорной информации настоящего изобретения, может быть применен к способу кодирования видео.

Следовательно, способ кодирования видео согласно настоящему изобретению используется для кодирования видеоизображения путем разделения всего изображения на области; выбора, для каждой области разделенного изображения, из множества уже кодированных кадров одного опорного кадра кодируемой целевой области, который используется в качестве опорного кадра при предсказании информации изображения этой области; генерации предсказанного изображения путем использования опорного кадра кодируемой целевой области и опорной информации (например, вектор движения или вектор расхождения), которая указывает предсказанную целевую позицию кодируемой целевой области в опорном кадре кодируемой целевой области; и кодирования информации разности между предсказанным изображением и изображением кодируемой целевой области. Способ кодирования видео включает в себя:

(a) этап установки данных предсказания предсказанной опорной информации, на котором устанавливают опорную информацию, которая была использована при кодировании области, смежной с кодируемой целевой областью, в качестве данных предсказания предсказанной опорной информации, используемых для предсказания опорной информации кодируемой целевой области;

(b) этап генерации опорной информации опорной области, на котором генерируют опорную информацию опорной области на основании одного или более кусков опорной информации, использованной при кодировании опорной области, указанной данными предсказания предсказанной опорной информации;

(c) этап обновления данных предсказания предсказанной опорной информации, на котором обновляют данные предсказания предсказанной опорной информации путем использования сгенерированной опорной информации опорной области;

(d) этап генерации предсказанной опорной информации, на котором генерируют предсказанную опорную информацию, которая исполняет роль предсказанной информации опорной информации кодируемой целевой области, путем использования одного или более кусков данных предсказания обновленной предсказанной опорной информации, и

(e) этап кодирования дифференциальной опорной информации, на котором кодируют информацию разности между предсказанной опорной информацией и опорной информацией, использованной при генерации предсказанного изображения кодируемой целевой области.

В типовом примере на этапе обновления данных предсказания предсказанной опорной информации данные предсказания предсказанной опорной информации обновляются путем замены информации корреспондирующих точек, указанной данными предсказания предсказанной опорной информации, на сумму информации корреспондирующих точек, указанной данными предсказания предсказанной опорной информации, и информации корреспондирующих точек, указанной опорной информацией опорной области.

В еще одном типовом примере на этапе обновления данных предсказания предсказанной опорной информации данные предсказания предсказанной опорной информации обновляются путем замены информации корреспондирующих точек, указанной данными предсказания предсказанной опорной информации, на информацию корреспондирующих точек, указанную опорной информацией опорной области.

Предпочтительно, на этапе обновления данных предсказания предсказанной опорной информации данные предсказания предсказанной опорной информации обновляются путем замены информации корреспондирующих точек, указанной данными предсказания предсказанной опорной информации, либо на сумму информации корреспондирующих точек, указанной данными предсказания предсказанной опорной информации, и информации корреспондирующих точек, указанной опорной информацией опорной области, либо на информацию корреспондирующих точек опорной информации опорной области.

В этом случае представляется возможным, что на этапе обновления данных предсказания предсказанной опорной информации определяется, была ли заменена информация корреспондирующих точек данных предсказания предсказанной опорной информации на сумму информации корреспондирующих точек данных предсказания предсказанной опорной информации и информации корреспондирующих точек опорной информации опорной точки или на информацию корреспондирующих точек опорной информации опорной области, на основании информации времени и информации точки обзора опорного кадра кодируемой целевой области, информации времени и информации точки обзора кадра, который включает в себя опорную область, информации времени и информации точки обзора опорного кадра опорной области, который представляет собой опорный кадр, используемый при кодировании опорной области, и информации времени и информации точки обзора кодируемого целевого кадра.

Предпочтительный пример дополнительно включает в себя этап геометрического преобразования предсказанной опорной информации, на котором применяют геометрическое преобразование к информации корреспондирующих точек, указанной данными предсказания предсказанной опорной информации, путем использования параметра камеры на точке обзора кодируемого целевого кадра, параметра камеры на точке обзора опорного кадра кодируемой целевой области и параметра камеры на точке обзора кадра, указанного данными предсказания предсказанной опорной информации.

Еще один предпочтительный пример дополнительно включает в себя этап геометрического преобразования предсказанной опорной информации, на котором применяют геометрическое преобразование к информации корреспондирующих точек, указанной опорной информацией опорной области, путем использования параметра камеры на точке обзора кодируемого целевого кадра, параметра камеры на точке обзора опорного кадра кодируемой целевой области, параметра камеры на точке обзора кадра, указанного данными предсказания предсказанной опорной информации, и параметра камеры на точке обзора кадра, указанного опорной информацией опорной области, соответствующей данным предсказания предсказанной опорной информации.

Еще один предпочтительный пример дополнительно включает в себя этап поиска данных предсказания предсказанной опорной информации, на котором выполняют поиск цели, которая представляет собой область в опорном кадре кодируемой целевой области, для области, соответствующей опорной области, указанной данными предсказания предсказанной опорной информации, и заменяют данные предсказания предсказанной опорной информации на соответствующую информацию результата поиска.

На этапе поиска данных предсказания предсказанной опорной информации может быть выполнен поиск, в котором центр поиска устанавливается на область, указанную вышеупомянутой соответствующей информацией для данных предсказания предсказанной опорной информации, и данные предсказания предсказанной опорной информации могут быть заменены на информацию согласно результату поиска.

Еще один предпочтительный пример дополнительно включает в себя этап поиска данных предсказания предсказанной опорной информации, на котором выполняют поиск цели, которая представляет собой область в опорном кадре кодируемой целевой области, для области, соответствующей области, которая является смежной относительно кодируемой целевой области, и заменяют данные предсказания предсказанной опорной информации на соответствующую информацию результата поиска.

На этапе поиска данных предсказания предсказанной опорной информации может быть выполнен поиск, при котором центр поиска устанавливается на область, указанную вышеупомянутой соответствующей информацией для данных предсказания предсказанной опорной информации, и данные предсказания предсказанной опорной информации могут быть заменены на информацию согласно результату поиска.

(3) Способ декодирования видео согласно настоящему изобретению

Способ генерации предсказанной опорной информации настоящего изобретения, который может быть реализован посредством вышеупомянутого устройства генерации предсказанной опорной информации настоящего изобретения, может быть применен к способу декодирования видео.

Ниже описан способ декодирования видео, реализуемой посредством способа генерации предсказанной опорной информации согласно настоящему изобретению.

Так, способ декодирования видео согласно настоящему изобретению используется для декодирования изображения путем разделения всего изображения на области и генерации предсказанного изображения путем использования множества уже декодированных кадров, причем видеоизображение декодируется путем декодирования, для каждой области разделенного изображения, информации для указания опорного кадра декодируемой целевой области, который представляет собой уже декодированный кадр, использованный для генерации предсказанного изображения; опорной информации для указания предсказанной целевой позиции декодируемой целевой области в опорном кадре декодируемой целевой области; и информации разности между предсказанным изображением и изображением декодируемой целевой области. Способ декодирования видео включает в себя:

(a) этап установки данных предсказания предсказанной опорной информации, на котором устанавливают опорную информацию, которая была использована при декодировании области, смежной с декодируемой целевой областью, в качестве данных предсказания предсказанной опорной информации, используемых для предсказания опорной информации декодируемой целевой области;

(b) этап генерации опорной информации опорной области, на котором генерируют опорную информацию опорной области на основании одного или более кусков опорной информации, использованной при декодировании опорной области, указанной данными предсказания предсказанной опорной информации;

(c) этап обновления данных предсказания предсказанной опорной информации, на котором обновляют данные предсказания предсказанной опорной информации путем использования сгенерированной опорной информации опорной области;

(d) этап генерации предсказанной опорной информации, на котором генерируют предсказанную опорную информацию, которая исполняет роль предсказанной информации опорной информации декодируемой целевой области, путем использования одного или более кусков данных предсказания обновленной предсказанной опорной информации, и

(e) этап декодирования дифференциальной опорной информации, на котором из кодированных данных декодируют информацию разности между предсказанной опорной информацией и опорной информацией, использованной при генерации предсказанного изображения декодируемой целевой области.

В типовом примере на этапе обновления данных предсказания предсказанной опорной информации данные предсказания предсказанной опорной информации обновляются путем замены информации корреспондирующих точек, указанной данными предсказания предсказанной опорной информации, на сумму информации корреспондирующих точек, указанной данными предсказания предсказанной опорной информации, и информации корреспондирующих точек, указанной опорной информацией опорной области.

В еще одном типовом примере на этапе обновления данных предсказания предсказанной опорной информации данные предсказания предсказанной опорной информации обновляются путем замены информации корреспондирующих точек, указан