Устройство и способ для совмещения потоков пространственного аудиокодирования на основе геометрии

Иллюстрации

Показать всеИзобретение относится к средствам для формирования совмещенного потока аудиоданных. Технический результат заключается в обеспечении возможности формирования совмещенного потока аудиоданных. Устройство содержит демультиплексор для получения множества одноуровневых потоков аудиоданных, где демультиплексор приспособлен для приема одного или более входных потоков аудиоданных, где каждый входной поток аудиоданных содержит один или более уровней, где демультиплексор приспособлен для демультиплексирования каждого из входных потоков аудиоданных, имеющих один или более уровней, на два или более демультиплексированных потоков аудиоданных, имеющих ровно один уровень, так что упомянутые два или более демультиплексированных потоков аудиоданных вместе содержат упомянутый один или более уровней входного потока аудиоданных. Кроме того, устройство содержит модуль совмещения для формирования совмещенного потока аудиоданных, имеющего один или более уровней, на основе упомянутого множества одноуровневых потоков аудиоданных. 3 н. и 15 з.п. ф-лы, 44 ил.

Реферат

Настоящее изобретение относится к обработке аудиосигналов, и в частности, к устройству и способу для формирования совмещенного потока аудиоданных.

Становится все более и более важной обработка аудиосигналов, и в частности, пространственное аудиокодирование. Традиционная пространственная звукозапись стремится к захвату звукового поля так, что на стороне воспроизведения слушатель воспринимает звуковой образ таким, как он был в месте записи. Из современного уровня техники известны разные подходы к методикам пространственной звукозаписи и воспроизведения, которые могут основываться на канальном, объектном или параметрическом представлениях.

Канальные представления представляют звуковую сцену посредством N дискретных аудиосигналов, предназначенных для воспроизведения N громкоговорителями, размещенными по известной схеме, например схеме звукового окружения 5.1. Подход для пространственной звукозаписи обычно применяет расположенные на расстоянии, всенаправленные микрофоны, например, в стереофонии AB, или совмещенные направленные микрофоны, например, в интенсивностной стереофонии. В качестве альтернативы могут применяться более сложные микрофоны, например микрофон B-формата, например, в амбиофонии, см.:

[1] Michael A. Gerzon. Ambisonics in multichannel broadcasting and video. J. Audio Eng. Soc, 33(11):859-871, 1985.

Нужные сигналы громкоговорителей для известной схемы выводятся непосредственно из записанных сигналов микрофонов, а затем передаются или сохраняются по отдельности. Более эффективное представление получается путем применения к дискретным сигналам аудиокодирования, которое в некоторых случаях кодирует информацию разных каналов одновременно для повышенной эффективности, например, в MPEG-Surround для каналов 5.1, см.:

[21] J. Herre, K. Kjörling, J. Breebaart, C. Faller, S. Disch, H. Purnhagen, J. Koppens, J. Hilpert, J. Rödén, W. Oomen, K. Linzmeier, K.S. Chong: "MPEG Surround - The ISO/MPEG Standard for Efficient and Compatible Multichannel Audio Coding", 122nd AES Convention, Vienna, Austria, 2007, Preprint 7084.

Основным недостатком этих методик является то, что нельзя изменить звуковую сцену после того, как вычислены сигналы громкоговорителей.

Объектные представления используются, например, в Пространственном кодировании аудиообъектов (SAOC), см.

[25] Jeroen Breebaart, Jonas Engdegård, Cornelia Falch, Oliver Hellmuth, Johannes Hilpert, Andreas Hoelzer, Jeroens Koppens, Werner Oomen, Barbara Resch, Erik Schuijers, and Leonid Terentiev. Spatial audio object coding (saoc) - the upcoming mpeg standard on parametric object based audio coding. In Audio Engineering Society Convention 124, 5 2008.

Объектные представления представляют звуковую сцену с помощью N дискретных аудиообъектов. Это представление обеспечивает высокую гибкость на стороне воспроизведения, поскольку звуковой сценой можно манипулировать путем изменения, например, положения и громкости каждого объекта. Хотя это представление может быть без труда доступно, например, из многодорожечной записи, его очень трудно получить из сложной звуковой сцены, записанной незначительным количеством микрофонов (см., например, [21]). Фактически, говорящих (или другие звукоизлучающие объекты) сначала нужно локализовать, а затем извлечь из смеси, что могло бы послужить причиной артефактов.

Параметрические представления часто применяют пространственные микрофоны для определения одного или более аудиосигналов понижающего микширования вместе с дополнительной пространственной информацией, описывающей пространственный звук. Примером является Направленное аудиокодирование (DirAC), которое обсуждается в

[29] Ville Pulkki. Spatial sound reproduction with directional audio coding. J. Audio Eng. Soc, 55(6):503-516, June 2007.

Термин "пространственный микрофон" относится к любому устройству для получения пространственного звука, допускающего извлечение направления прихода звука (например, сочетание направленных микрофонов, микрофонные решетки и т. п. ).

Термин "непространственный микрофон" относится к любому устройству, которое не приспособлено для извлечения направления прихода звука, например одиночному всенаправленному или направленному микрофону.

Другой пример предлагается в:

[4] C. Faller. Microphone front-ends for spatial audio coders. In Proc. of the AES 125th International Convention, San Francisco, Oct. 2008.

В DirAC информация о пространственных метках содержит направление прихода (DOA) звука и диффузность звукового поля, вычисленную в частотно-временной области. Для воспроизведения звука аудиосигналы воспроизведения можно вывести на основе параметрического описания. Эти методики дают большую гибкость на стороне воспроизведения, потому что может применяться произвольная схема громкоговорителей, поскольку представление очень гибкое и компактное, так как содержит монофонический аудиосигнал понижающего микширования и дополнительную информацию и поскольку дает возможность простых изменений над звуковой сценой, например, акустическое масштабирование, направленную фильтрацию, совмещение сцен и т. п.

Однако эти методики по-прежнему ограничены в том, что записанный пространственный образ всегда относится к используемому пространственному микрофону. Поэтому нельзя менять акустическую "точку зрения", и нельзя изменять положение прослушивания в звуковой сцене.

Подход с виртуальным микрофоном представлен в

[22] Giovanni Del Galdo, Oliver Thiergart, Tobias Weller, and E. A. P. Habets. Generating virtual microphone signals using geometrical information gathered by distributed arrays. In Third Joint Workshop on Hands-free Speech Communication and Microphone Arrays (HSCMA ’11), Edinburgh, United Kingdom, May 2011,

который позволяет вычислить выходные сигналы произвольного пространственного микрофона, виртуально размещенного в окружении по желанию (то есть в произвольном положении и ориентации). Гибкость, отличающая подход с виртуальным микрофоном (VM), позволяет виртуально захватывать звуковую сцену по желанию на этапе постобработки, но не предоставляется никакое представление звукового поля, которое может использоваться для эффективной передачи и/или хранения и/или изменения звуковой сцены. Кроме того, предполагается активным только один источник на элемент разрешения по времени/частоте, и поэтому нельзя правильно описать звуковую сцену, если активны два или более источника в одном и том же элементе разрешения по времени/частоте. Кроме того, если виртуальный микрофон (VM) применяется на стороне приемника, то все сигналы микрофонов нужно отправлять по каналу, что делает представление неэффективным, тогда как если VM применяется на стороне передатчика, то звуковой сценой больше нельзя манипулировать, и модель утрачивает гибкость и становится ограниченной некоторой схемой громкоговорителей. Кроме того, он не рассматривает манипуляцию звуковой сценой на основе параметрической информации.

В

[24] Emmanuel Gallo and Nicolas Tsingos. Extracting and re-rendering structured auditory scenes from field recordings. In AES 30th International Conference on Intelligent Audio Environments, 2007,

оценка положения источника звука основывается на парной разности времени прихода, измеренной посредством разнесенных микрофонов. Кроме того, приемник зависит от записи и требует для синтеза (например, формирования сигналов громкоговорителей) все сигналы микрофонов.

Способ, представленный в

[28] Svein Berge. Device and method for converting spatial audio signal. US patent application, Appl. No. 10/547,151,

аналогично DirAC использует направление прихода в качестве параметра, соответственно ограничивая представление определенной точкой зрения звуковой сцены. Кроме того, он не предлагает возможность передавать/сохранять представление звуковой сцены, поскольку нужно применять анализ и синтез на одной и той же стороне системы связи.

Другим примером могут быть приложения видеоконференцсвязи, в которых участников, которые записываются в разных окружениях, нужно воспроизводить в единой звуковой сцене. Блок управления многосторонней связью (MCU) должен обеспечить, что воспроизводится единая звуковая сцена.

В

[22] G. Del Galdo, F.Kuech, M. Kallinger, and R. Schultz-Amling. Efficient merging of multiple audio streams for spatial sound reproduction in directional audio coding. In International Conference on Acoustics, Speech, and Signal Processing (ICASSP 2009), 2009

и в

[23] US 20110216908: Apparatus for Merging Spatial Audio Streams

предложена идея объединения двух или более параметрических представлений звуковой сцены.

Однако было бы очень полезно предоставить идеи для создания единой звуковой сцены из двух или более представлений звуковой сцены эффективным способом, достаточно гибким для изменения звуковой сцены.

Цель настоящего изобретения - предоставить усовершенствованные идеи для формирования совмещенного потока аудиоданных, например потока GAC. Цель настоящего изобретения достигается с помощью устройства по п. 1, способа по п. 17 и компьютерной программы по п. 18.

В соответствии с вариантом осуществления предоставляется устройство для формирования совмещенного потока аудиоданных. Устройство содержит демультиплексор для получения множества одноуровневых потоков аудиоданных, где демультиплексор приспособлен для приема одного или более входных потоков аудиоданных, где каждый входной поток аудиоданных содержит один или более уровней, где демультиплексор приспособлен для демультиплексирования каждого из входных потоков аудиоданных, имеющих один или более уровней, на два или более демультиплексированных потоков аудиоданных, имеющих ровно один уровень, так что один или более демультиплексированных потоков аудиоданных вместе содержат упомянутый один или более уровней входных потоков аудиоданных, чтобы предоставить два или более одноуровневых потоков аудиоданных. Кроме того, устройство содержит модуль совмещения для формирования совмещенного потока аудиоданных, имеющего один или более уровней, на основе упомянутого множества одноуровневых потоков аудиоданных, например на основе упомянутого множества демультиплексированных одноуровневых потоков аудиоданных. Каждый уровень входных потоков аудиоданных, демультиплексированных потоков аудиоданных, одноуровневых потоков данных и совмещенного потока аудиоданных содержит значение давления сигнала давления, значение положения и значение диффузности в качестве аудиоданных.

В дополнительном варианте осуществления устройство может содержать демультиплексор для получения множества одноуровневых потоков аудиоданных, где демультиплексор приспособлен для приема двух или более входных потоков аудиоданных, где каждый входной поток аудиоданных содержит один или более уровней, где демультиплексор приспособлен для демультиплексирования каждого из входных потоков аудиоданных, имеющих два или более уровней, на два или более демультиплексированных потоков аудиоданных, имеющих ровно один уровень, так что упомянутые два или более демультиплексированных потоков аудиоданных вместе содержат упомянутые два или более уровней входных потоков аудиоданных, чтобы получить два или более одноуровневых потоков аудиоданных. Кроме того, устройство может содержать модуль совмещения для формирования совмещенного потока аудиоданных, имеющего один или более уровней, на основе упомянутого множества одноуровневых потоков аудиоданных.

В варианте осуществления устройство может быть приспособлено для подачи одного или более принятых входных потоков аудиоданных, имеющих ровно один уровень, непосредственно в модуль совмещения без их подачи в демультиплексор.

Каждый уровень входных потоков аудиоданных, демультиплексированных потоков аудиоданных, одноуровневых потоков данных и совмещенного потока аудиоданных содержит значение давления сигнала давления, значение положения и значение диффузности в качестве аудиоданных, причем аудиоданные задаются для элемента разрешения по времени/частоте множества элементов разрешения по времени/частоте.

В соответствии с этим вариантом осуществления две или более записанные звуковые сцены совмещаются в одну посредством совмещения двух или более потоков аудиоданных, например потоков GAC, и путем вывода одиночного потока аудиоданных, например одиночного потока GAC.

Совмещение звуковых сцен может использоваться, например, в приложениях видеоконференцсвязи, участников, записываемых в разных окружениях, нужно воспроизводить в единой звуковой сцене. Поэтому совмещение может происходить в Блоке управления многосторонней связью (MCU), чтобы уменьшить сетевой трафик, или у конечных пользователей, чтобы уменьшить вычислительные затраты синтеза (например, вычисления сигналов громкоговорителей).

В варианте осуществления модуль совмещения может содержать модуль функции стоимости для назначения значения стоимости каждому из одноуровневых потоков аудиоданных, и где модуль совмещения может быть приспособлен для формирования совмещенного потока аудиоданных на основе значений стоимости, назначенных одноуровневым потокам аудиоданных.

В соответствии с другим вариантом осуществления модуль функции стоимости может быть приспособлен для назначения значения стоимости каждому из одноуровневых потоков аудиоданных в зависимости от по меньшей мере одного из значений давления или значений диффузности одноуровневого потока аудиоданных.

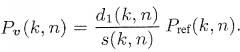

В дополнительном варианте осуществления модуль функции стоимости может быть приспособлен для назначения значения стоимости каждому потоку аудиоданных группы одноуровневых потоков аудиоданных путем применения формулы:

где Pi - значение давления, а ψi - значение диффузности уровня i-го потока аудиоданных группы одноуровневых потоков аудиоданных, например, для каждого элемента разрешения по времени/частоте.

В соответствии с другим вариантом осуществления модуль совмещения, кроме того, может содержать блок совмещения давления, где блок совмещения давления может быть приспособлен для определения первой группы, содержащей один или более одноуровневых потоков аудиоданных упомянутого множества одноуровневых потоков аудиоданных, и для определения второй группы, содержащей один или более других одноуровневых потоков аудиоданных упомянутого множества одноуровневых потоков аудиоданных, где значение стоимости каждого из одноуровневых потоков аудиоданных первой группы может быть больше значения стоимости каждого из одноуровневых потоков аудиоданных второй группы, либо где значение стоимости каждого из одноуровневых потоков аудиоданных первой группы может быть меньше значения стоимости каждого из одноуровневых потоков аудиоданных второй группы, где блок совмещения давления может быть приспособлен для формирования упомянутого одного или более значений давления упомянутого одного или более уровней совмещенного потока аудиоданных, так что каждое значение давления каждого из одноуровневых потоков аудиоданных первой группы может быть значением давления одного из уровней совмещенного потока аудиоданных, и так что сочетание значений давления одноуровневых потоков аудиоданных второй группы может быть значением давления одного из уровней совмещенного потока аудиоданных.

В дополнительном варианте осуществления модуль совмещения, кроме того, может содержать блок совмещения диффузности, где блок совмещения диффузности может быть приспособлен для определения третьей группы, содержащей один или более одноуровневых потоков аудиоданных упомянутого множества одноуровневых потоков аудиоданных, и для определения четвертой группы, содержащей один или более других одноуровневых потоков аудиоданных упомянутого множества одноуровневых потоков аудиоданных. Значение стоимости каждого из одноуровневых потоков аудиоданных третьей группы может быть больше значения стоимости каждого из одноуровневых потоков аудиоданных четвертой группы, либо где значение стоимости каждого из одноуровневых потоков аудиоданных третьей группы может быть меньше значения стоимости каждого из одноуровневых потоков аудиоданных четвертой группы, где блок совмещения диффузности может быть приспособлен для формирования упомянутого одного или более значений диффузности упомянутого одного или более уровней совмещенного потока аудиоданных, так что каждое значение диффузности каждого из одноуровневых потоков аудиоданных третьей группы может быть значением диффузности одного из уровней совмещенного потока аудиоданных, и так что сочетание значений диффузности одноуровневых потоков аудиоданных четвертой группы может быть значением диффузности одного из уровней совмещенного потока аудиоданных.

В соответствии с другим вариантом осуществления модуль совмещения, кроме того, может содержать блок (1403) смешивания положений, где блок (1403) смешивания положений может быть приспособлен для определения пятой группы, содержащей один или более одноуровневых потоков аудиоданных упомянутого множества одноуровневых потоков аудиоданных, где значение стоимости каждого из одноуровневых потоков аудиоданных пятой группы может быть больше значения стоимости любых одноуровневых потоков аудиоданных, не содержащихся в пятой группе упомянутого множества одноуровневых потоков аудиоданных, либо где значение стоимости каждого из одноуровневых потоков аудиоданных пятой группы меньше значения стоимости любых одноуровневых потоков аудиоданных, не содержащихся в пятой группе упомянутого множества одноуровневых потоков аудиоданных. Блок (1403) смешивания положений может быть приспособлен для формирования упомянутого одного или более значений положения упомянутого одного или более уровней совмещенного потока аудиоданных, так что каждое значение положения каждого из одноуровневых потоков аудиоданных пятой группы может быть значением положения одного из уровней совмещенного потока аудиоданных.

В другом варианте осуществления модуль совмещения, кроме того, может содержать модуль адаптации звуковой сцены для манипулирования значением положения одного или более одноуровневых потоков аудиоданных упомянутого множества одноуровневых потоков аудиоданных.

В соответствии с дополнительным вариантом осуществления модуль адаптации звуковой сцены может быть приспособлен для манипулирования значением положения одного или более одноуровневых потоков аудиоданных упомянутого множества одноуровневых потоков аудиоданных, применяя вращение, перенос или нелинейное преобразование в отношении значения положения.

В другом варианте осуществления демультиплексор может содержать множество блоков демультиплексирования, где каждый из блоков демультиплексирования может конфигурироваться для демультиплексирования одного или более входных потоков аудиоданных.

В соответствии с дополнительным вариантом осуществления устройство, кроме того, может содержать генератор искусственного источника звука для формирования искусственного потока данных, содержащего ровно один уровень, где генератор искусственного источника может быть приспособлен для приема информации о давлении, представляемой во временной области, и для приема информации о положении, где генератор искусственного источника может быть приспособлен для дублирования информации о давлении, чтобы сформировать информацию о положении для множества элементов разрешения по времени/частоте, и где генератор искусственного источника, кроме того, может быть приспособлен для вычисления информации о диффузности на основе информации о давлении.

В другом варианте осуществления генератор искусственного источника может быть приспособлен для преобразования информации о давлении, представляемой во временной области, в частотно-временную область.

В соответствии с дополнительным вариантом осуществления генератор искусственного источника может быть приспособлен для добавления реверберации в информацию о давлении.

Другой вариант осуществления позволяет вставить искусственный источник звука в звуковую сцену. Вставка искусственного источника звука особенно полезна в приложениях типа виртуальной реальности и видеоигр, в которых сложная звуковая сцена может быть заполнена синтетическими источниками. В сценариях телеконференцсвязи вставка полезна при объединении участников, взаимодействующих посредством монофонического канала, например, звонящих по мобильным телефонам.

Ниже будут описываться предпочтительные варианты осуществления настоящего изобретения, где:

Фиг. 1 иллюстрирует устройство для формирования совмещенного потока аудиоданных в соответствии с вариантом осуществления,

Фиг. 2a иллюстрирует устройство для формирования по меньшей мере одного выходного аудиосигнала на основе потока аудиоданных, содержащего аудиоданные, относящиеся к одному или нескольким источникам звука, в соответствии с вариантом осуществления,

Фиг. 2b иллюстрирует устройство для формирования потока аудиоданных, содержащего данные источника звука, относящиеся к одному или нескольким источникам звука, в соответствии с вариантом осуществления,

Фиг. 3a-3c иллюстрируют потоки аудиоданных в соответствии с разными вариантами осуществления,

Фиг. 4 иллюстрирует устройство для формирования потока аудиоданных, содержащего данные источника звука, относящиеся к одному или нескольким источникам звука, в соответствии с другим вариантом осуществления,

Фиг. 5 иллюстрирует звуковую сцену, состоящую из двух источников звука и двух однородных линейных микрофонных решеток,

Фиг. 6a иллюстрирует устройство 600 для формирования по меньшей мере одного выходного аудиосигнала на основе потока аудиоданных в соответствии с вариантом осуществления,

Фиг. 6b иллюстрирует устройство 660 для формирования потока аудиоданных, содержащего данные источника звука, относящиеся к одному или нескольким источникам звука, в соответствии с вариантом осуществления,

Фиг. 7 изображает модуль модифицирования в соответствии с вариантом осуществления,

Фиг. 8 изображает модуль модифицирования в соответствии с другим вариантом осуществления,

Фиг. 9 иллюстрирует блоки передатчика/анализа и блоки приемника/синтеза в соответствии с вариантом осуществления,

Фиг. 10a изображает модуль синтеза в соответствии с вариантом осуществления,

Фиг. 10b изображает блок первого этапа синтеза в соответствии с вариантом осуществления,

Фиг. 10c изображает блок второго этапа синтеза в соответствии с вариантом осуществления,

Фиг. 11 изображает модуль синтеза в соответствии с другим вариантом осуществления,

Фиг. 12 иллюстрирует устройство для формирования выходного аудиосигнала виртуального микрофона в соответствии с вариантом осуществления,

Фиг. 13 иллюстрирует входы и выходы устройства и способ для формирования выходного аудиосигнала виртуального микрофона в соответствии с вариантом осуществления,

Фиг. 14 иллюстрирует базовую структуру устройства для формирования выходного аудиосигнала виртуального микрофона в соответствии с вариантом осуществления, которое содержит блок оценки положения звуковых событий и модуль вычисления информации,

Фиг. 15 показывает типовой сценарий, в котором реальные пространственные микрофоны изображаются как Однородные линейные решетки из 3 микрофонов каждая,

Фиг. 16 изображает два пространственных микрофона в трех измерениях для оценивания направления прихода в трехмерном пространстве,

Фиг. 17 иллюстрирует геометрию, где изотропный точечный источник звука текущего элемента разрешения по времени/частоте (k, n) располагается в положении pIPLS(k, n),

Фиг. 18 изображает модуль вычисления информации в соответствии с вариантом осуществления,

Фиг. 19 изображает модуль вычисления информации в соответствии с другим вариантом осуществления,

Фиг. 20 показывает два реальных пространственных микрофона, локализованное звуковое событие и положение виртуального пространственного микрофона,

Фиг. 21 иллюстрирует, как получить направление прихода относительно виртуального микрофона в соответствии с вариантом осуществления,

Фиг. 22 изображает возможный способ выведения DOA звука с точки зрения виртуального микрофона в соответствии с вариантом осуществления,

Фиг. 23 иллюстрирует блок вычисления информации, содержащий блок вычисления диффузности в соответствии с вариантом осуществления,

Фиг. 24 изображает блок вычисления диффузности в соответствии с вариантом осуществления,

Фиг. 25 иллюстрирует сценарий, где оценка положения звуковых событий невозможна,

Фиг. 26 иллюстрирует устройство для формирования потока данных виртуального микрофона в соответствии с вариантом осуществления, и

Фиг. 27 иллюстрирует устройство для формирования по меньшей мере одного выходного аудиосигнала на основе потока аудиоданных в соответствии с другим вариантом осуществления,

Фиг. 28 изображает входы и выходы устройства для формирования совмещенного потока аудиоданных в соответствии с другим вариантом осуществления,

Фиг. 29 иллюстрирует устройство для формирования совмещенного потока аудиоданных в соответствии с другим вариантом осуществления,

Фиг. 30 изображает модуль совмещения в соответствии с вариантом осуществления,

Фиг. 31a-31c изображают возможные сценарии звуковой сцены, и

Фиг. 32a-32b иллюстрируют генераторы искусственных источников в соответствии с вариантами осуществления,

Фиг. 33a-33c иллюстрируют сценарии, где две микрофонные решетки принимают прямой звук, отраженный стеной звук и диффузный звук.

Перед предоставлением подробного описания вариантов осуществления настоящего изобретения описывается устройство для формирования выходного аудиосигнала виртуального микрофона, чтобы предоставить вспомогательную информацию касательно идей настоящего изобретения.

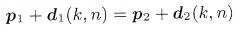

Фиг. 12 иллюстрирует устройство для формирования выходного аудиосигнала, чтобы имитировать запись микрофона в конфигурируемом виртуальном положении posVmic в окружении. Устройство содержит блок 110 оценки положения звуковых событий и модуль 120 вычисления информации. Блок 110 оценки положения звуковых событий принимает первую информацию di1 о направлении от первого реального пространственного микрофона и вторую информацию di2 о направлении от второго реального пространственного микрофона. Блок 110 оценки положения звуковых событий приспособлен для оценивания положения ssp источника звука, указывающего положение источника звука в окружении, причем источник звука излучает звуковую волну, где блок 110 оценки положения звуковых событий приспособлен для оценивания положения ssp источника звука на основе первой информации di1 о направлении, предоставленной первым реальным пространственным микрофоном, располагаемым в положении pos1mic первого реального микрофона в окружении, и на основе второй информации di2 о направлении, предоставленной вторым реальным пространственным микрофоном, располагаемым в положении второго реального микрофона в окружении. Модуль 120 вычисления информации приспособлен для формирования выходного аудиосигнала на основе первого записанного входного аудиосигнала is1, записываемого первым реальным пространственным микрофоном, на основе положения pos1mic первого реального микрофона и на основе виртуального положения posVmic виртуального микрофона. Модуль 120 вычисления информации содержит компенсатор распространения, приспосабливаемый для формирования первого измененного аудиосигнала путем изменения первого записанного входного аудиосигнала is1 путем компенсации первой задержки или затухания амплитуды между приходом звуковой волны, излученной источником звука, в первый реальный пространственный микрофон и приходом звуковой волны в виртуальный микрофон путем регулирования значения амплитуды, значения величины или значения фазы у первого записанного входного аудиосигнала is1, чтобы получить выходной аудиосигнал.

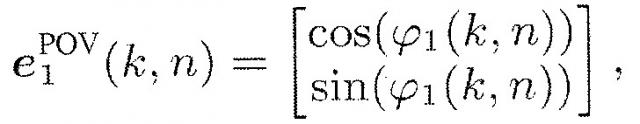

Фиг. 13 иллюстрирует входы и выходы устройства и способ в соответствии с вариантом осуществления. Информация 111, 112, …, 11N от двух или более реальных пространственных микрофонов подается в устройство/обрабатывается с помощью способа. Эта информация содержит аудиосигналы, зафиксированные реальными пространственными микрофонами, а также информацию о направлении от реальных пространственных микрофонов, например оценки направления прихода (DOA). Аудиосигналы и информация о направлении, например оценки направления прихода, могут выражаться в частотно-временной области. Если, например, нужно восстановление двумерной геометрии, и область традиционного STFT (оконное преобразование Фурье) выбирается для представления сигналов, то DOA можно выразить в виде азимутальных углов, зависимых от k и n, а именно от показателей частоты и времени.

В вариантах осуществления локализация звуковых событий в пространстве, а также описание положения виртуального микрофона могут проводиться на основе положений и ориентаций реального и виртуального пространственных микрофонов в общей системе координат. Эту информация можно представить с помощью входов 121…12N и входа 104 на фиг. 13. Вход 104 может дополнительно задавать характеристику виртуального пространственного микрофона, например, его положение и диаграмму направленности, что будет обсуждаться ниже. Если виртуальный пространственный микрофон содержит несколько виртуальных датчиков, то можно принять во внимание их положения и соответствующие разные диаграммы направленности.

Выходом устройства или соответствующего способа может быть, если нужно, один или более аудиосигналов 105, которые могут быть зафиксированы пространственным микрофоном, заданным и помещенным, как указано входом 104. Кроме того, устройство (или, точнее, способ) в качестве выхода может предоставить соответствующую дополнительную пространственную информацию 106, которая может оцениваться путем применения виртуального пространственного микрофона.

Фиг. 14 иллюстрирует устройство в соответствии с вариантом осуществления, которое содержит два главных блока обработки, блок 201 оценки положения звуковых событий и модуль 202 вычисления информации. Блок 201 оценки положения звуковых событий может осуществлять геометрическое восстановление на основе DOA, содержащихся во входах 111…11N, и на основе сведений о положении и ориентации реальных пространственных микрофонов, где вычислены DOA. Выход 205 блока оценки положения звуковых событий содержит оценки положений (либо в двух измерениях, либо в трех измерениях) источников звука, где возникают звуковые события, для каждого элемента разрешения по времени и частоте. Второй блок 202 обработки является модулем вычисления информации. В соответствии с вариантом осуществления из фиг. 14 второй блок 202 обработки вычисляет сигнал виртуального микрофона и дополнительную пространственную информацию. Поэтому он также называется блоком 202 вычисления сигнала виртуального микрофона и дополнительной информации. Блок 202 вычисления сигнала виртуального микрофона и дополнительной информации использует положения 205 звуковых событий для обработки аудиосигналов, содержащихся в 111…11N, чтобы вывести аудиосигнал 105 виртуального микрофона. Если необходимо, то блок 202 также может вычислять дополнительную пространственную информацию 106, соответствующую виртуальному пространственному микрофону. Варианты осуществления ниже иллюстрируют возможности того, как могут работать блоки 201 и 202.

Ниже подробнее описывается оценка положения в блоке оценки положения звуковых событий в соответствии с вариантом осуществления.

В зависимости от размерности проблемы (двумерная или трехмерная) и количества пространственных микрофонов возможно несколько решений для оценки положения.

Если существует два пространственных микрофона в двух измерениях (самый простой возможный случай), то возможна простая триангуляция. Фиг. 15 показывает типовой сценарий, в котором реальные пространственные микрофоны изображаются как Однородные линейные решетки (ULA) из 3 микрофонов каждая. DOA, выраженное в виде азимутальных углов a1(k, n) и a2(k, n), вычисляется для элемента разрешения по времени/частоте (k, n). Это достигается путем применения надлежащего блока оценки DOA, например ESPRIT,

[13] R. Roy, A. Paulraj, and T. Kailath, "Direction-of-arrival estimation by subspace rotation methods - ESPRIT," in IEEE International Conference on Acoustics, Speech, and Signal Processing (ICASSP), Stanford, CA, USA, April 1986,

или (root) MUSIC, см.

[14] R. Schmidt, “Multiple emitter location and signal parameter estimation,” IEEE Transactions on Antennas and Propagation, vol. 34, no. 3, pp. 276-280, 1986

к сигналам давления, преобразованным в частотно-временную область.

На фиг. 15 иллюстрируются два реальных пространственных микрофона, здесь - две реальные пространственные микрофонные решетки 410, 420. Два оцененных DOA a1(k, n) и a2(k, n) представляются двумя линиями, причем первая линия 430 представляет DOA a1(k, n), а вторая линия 440 представляет DOA a2(k, n). Возможна триангуляция посредством простых геометрических соображений, зная положение и ориентацию каждой решетки.

Триангуляция терпит неудачу, когда две линии 430, 440 точно параллельны. Однако в реальных применениях это очень маловероятно. Однако не все результаты триангуляции соответствуют физическому или правдоподобному положению для звукового события в рассматриваемом пространстве. Например, оцененное положение звукового события могло бы находиться слишком далеко или даже вне предполагаемого пространства, указывая, что DOA, возможно, не соответствуют никакому звуковому событию, которое можно физически интерпретировать с помощью используемой модели. Такие результаты могут быть обусловлены шумом датчика или слишком сильной реверберацией в помещении. Поэтому в соответствии с вариантом осуществления такие нежелательные результаты помечаются, так что модуль 202 вычисления информации может обращаться с ними должным образом.

Фиг. 16 изображает сценарий, где положение звукового события оценивается в трехмерном пространстве. Применяются надлежащие пространственные микрофоны, например, плоская или трехмерная микрофонная решетка. На фиг. 16 иллюстрируется первый пространственный микрофон 510, например, первая трехмерная микрофонная решетка, и второй пространственный микрофон 520, например вторая трехмерная микрофонная решетка. DOA в трехмерном пространстве, например, может выражаться в виде азимута и возвышения. Для выражения DOA могут применяться единичные векторы 530, 540. Две линии 550, 560 проецируются в соответствии с DOA. В трех измерениях даже при очень надежных оценках две линии 550, 560, спроецированные в соответствии с DOA, могут не пересекаться. Однако триангуляцию все же можно осуществить, например, путем выбора средней точки наименьшего отрезка, соединяющего две линии.

Аналогично двумерному случаю, триангуляция может потерпеть неудачу или может дать неправдоподобные результаты для некоторых сочетаний направлений, которые также можно пометить, например, для модуля 202 вычисления информации из фиг. 14.

Если существует более двух пространственных микрофонов, то возможно несколько решений. Например, объясненная выше триангуляция могла бы осуществляться для всех пар реальных пространственных микрофонов (если N=3, то 1 с 2, 1 с 3 и 2 с 3). Результирующие положения затем можно усреднить (по оси x и y, а если рассматривается три измерения - то z).

В качестве альтернативы могут использоваться более сложные идеи. Например, могут применяться вероятностные подходы, которые описаны в

[15] J. Michael Steele, "Optimal Triangulation of Random Samples in the Plane", The Annals of Probability, Vol. 10, No.3 (Aug., 1982), pp. 548-553.

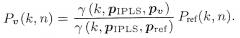

В соответствии с вариантом осуществления звуковое поле можно анализировать в частотно-временной области, например, полученной посредством оконного преобразования Фурье (STFT), в котором k и n обозначают соответственно показатель k частоты и показатель n времени. Комплексное давление Pv(k, n) в произвольном положении pv для некоторых k и n моделируется в виде одиночной сферической волны, излученной узкополосным изотропным точечным источником, например, путем применения формулы:

(1)

где PIPLS(k, n) является сигналом, излученным IPLS в положении pIPLS(k, n). Комплексный множитель γ(k, pIPLS, pv) выражает распространение от pIPLS(k, n) до pv, например, он вносит подходящие изменения фазы и величины. Здесь может применяться допущение, что в каждом элементе разрешения по времени/частоте активен только один IPLS. Тем не менее несколько узкополосных IPLS, расположенных в разных положениях, также могут быть активны в один момент времени.

Каждый IPLS моделирует либо прямой звук, либо отдельное отражение в помещении. Его положение pIPLS(k, n) в идеале может соответствовать фактическому источнику звука, расположенному внутри помещения, либо источнику звука с зеркальным отражением, расположенному соответственно снаружи. Поэтому положение pIPLS(k, n) т