Устройство вычисления собственного местоположения и способ вычисления собственного местоположения

Иллюстрации

Показать всеИзобретение относится к устройству вычисления собственного местоположения позиции и к способу вычисления собственной позиции. Устройство вычисления собственного местоположения по настоящему изобретению проецирует структурированный свет на поверхность дороги вокруг транспортного средства, захватывает и получает изображение поверхности дороги вокруг транспортного средства. При определении того, что состояние поверхности дороги вокруг транспортного средства изменяется вплоть до или больше порогового значения, устройство вычисления собственного местоположения вычисляет текущую позицию и текущий угол ориентации транспортного средства в данный момент посредством суммирования величины изменения ориентации с текущей позицией и текущим углом ориентации транспортного средства, которые вычисляются в предыдущем цикле обработки информации. Обеспечивается точное вычисление собственного местоположения транспортного средства даже в случаях, если поверхность дороги вокруг транспортного средства неровная или ухабистая. 2 н. и 2 з.п. ф-лы, 13 ил.

Реферат

Область техники, к которой относится изобретение

[0001] Настоящее изобретение относится к устройству вычисления собственного местоположения позиции и к способу вычисления собственного местоположения.

Уровень техники

[0002] Известна технология, в которой: камеры, установленные в транспортном средстве, захватывают и получают изображения окрестности транспортного средства; и величина перемещения транспортного средства получается на основе изменений изображений (см. патентный документ 1). Патентный документ 1 направлен на точное получение величины перемещения транспортного средства, даже если транспортное средство перемещается незначительно на низкой скорости. С этой целью, характерная точка обнаруживается из каждого изображения; позиция характерной точки получается; и в силу этого величина перемещения транспортного средства получается из направления и расстояния перемещения (величины перемещения) характерной точки.

Список библиографических ссылок

Патентные документы

[0003] Патентный документ 1. Публикация заявки на патент Японии номер 2008-175717

Сущность изобретения

Техническая задача

[0004] Тем не менее, вышеприведенная обычная технология имеет такую проблему, что когда поверхность дороги вокруг транспортного средства является неровной или ухабистой, технология не позволяет точно вычислять позицию транспортного средства.

Решение задачи

[0005] Настоящее изобретение предложено с учетом вышеприведенной ситуации. Цель настоящего изобретения заключается в том, чтобы предоставлять устройство вычисления собственного местоположения и способ вычисления собственного местоположения, которые допускают точное вычисление собственного местоположения транспортного средства даже в случае, если поверхность дороги вокруг транспортного средства является неровной или ухабистой.

[0006] В целях решения вышеприведенной проблемы, устройство вычисления собственного местоположения по одному аспекту настоящего изобретения захватывает и за счет этого получает изображение поверхности дороги вокруг транспортного средства, на которое проецируется структурированный свет, и вычисляет угол ориентации транспортного средства относительно поверхности дороги из позиции структурированного света в изображении. Кроме того, устройство вычисления собственного местоположения вычисляет величину изменения ориентации транспортного средства на основе временных изменений нескольких характерных точек на поверхности дороги в полученном изображении и вычисляет текущую позицию и текущий угол ориентации транспортного средства посредством суммирования величины изменения ориентации с начальной позицией и углом ориентации транспортного средства. После этого, при определении того, что состояние поверхности дороги вокруг транспортного средства изменяется вплоть до или больше порогового значения, устройство вычисления собственного местоположения вычисляет текущую позицию и текущий угол ориентации транспортного средства посредством суммирования величины изменения ориентации с текущей позицией и текущим углом ориентации транспортного средства, которые вычисляются в предыдущем цикле обработки информации.

Краткое описание чертежей

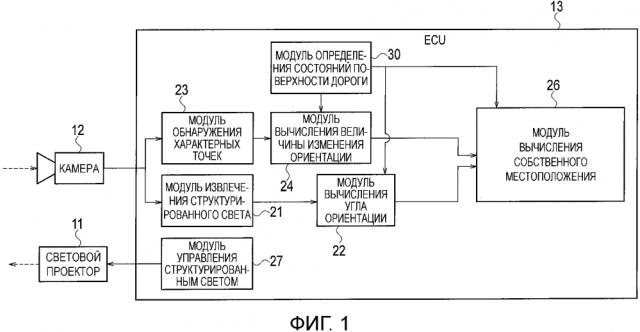

[0007] Фиг.1 является блок-схемой, показывающей общую конфигурацию устройства вычисления собственного местоположения по первому варианту осуществления.

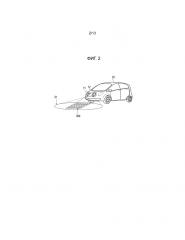

Фиг.2 является внешним видом, показывающим пример того, как световой проектор и камера устанавливаются в транспортном средстве.

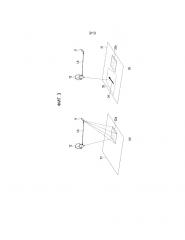

Фиг.3(a) является схемой, показывающей то, как вычисляется позиция областей световых пятен на поверхности дороги посредством использования светового проектора и камеры. Фиг.3(b) является схемой, показывающей то, как направление перемещения камеры получается из временных изменений характерной точки, которая обнаруживается за пределами области, на которую проецируется структурированный свет.

Фиг.4 является схемой, показывающей изображение структурированного света, которое получается посредством применения процесса преобразования в двоичную форму к изображению, полученному с помощью камеры. Фиг.4(a) является схемой, полностью показывающей структурированный свет. Фиг.4(b) является увеличенной схемой, показывающей одно световое пятно. Фиг.4(c) является схемой, показывающей позицию центра тяжести световых пятен.

Фиг.5 является принципиальной схемой для описания способа вычисления величин изменений расстояния и угла ориентации.

Фиг.6 является схемой, показывающей характерные точки, обнаруженные в изображении. Фиг.6(a) является схемой, показывающей первый кадр (изображение), полученный во время t. Фиг.6(b) является схемой, показывающей второй кадр, полученный во время t+Δt.

Фиг.7 является схемой для описания того, как оценивать величину изменения высоты поверхности дороги из позиции структурированного света.

Фиг.8 является временной диаграммой, показывающей процесс, в котором устройство вычисления собственного местоположения по первому варианту осуществления выполняет определение относительно изменений состояния поверхности дороги.

Фиг.9 является блок-схемой последовательности операций способа, показывающей процедуру для процесса вычисления собственного местоположения, который должен выполняться посредством устройства вычисления собственного местоположения по первому варианту осуществления.

Фиг.10 является блок-схемой последовательности операций способа, показывающей процедуру для подробного процесса на этапе S09 на фиг.9, который должен выполняться посредством устройства вычисления собственного местоположения по первому варианту осуществления.

Фиг.11 является схемой, показывающей пример ошибки в оценке угла крена транспортного средства и пример ошибки в оценке величины перемещения транспортного средства.

Фиг.12 является временной диаграммой, показывающей процесс, в котором устройство вычисления собственного местоположения по второму варианту осуществления выполняет определение относительно изменений состояния поверхности дороги.

Фиг.13 является блок-схемой последовательности операций способа, показывающей процедуру для подробного процесса на этапе S09 на фиг.9, который должен выполняться посредством устройства вычисления собственного местоположения по второму варианту осуществления.

Подробное описание вариантов осуществления

[0008] Со ссылкой на чертежи, ниже предоставляется описание для первого и второго вариантов осуществления, к которым применяется настоящее изобретение.

[0009] Первый вариант осуществления

Аппаратная конфигурация

Для начала, со ссылкой на фиг.1, ниже предоставляется описание аппаратной конфигурации устройства вычисления собственного местоположения по первому варианту осуществления. Устройство вычисления собственного местоположения включает в себя световой проектор 11, камеру 12 и модуль 13 управления двигателем (ECU). Световой проектор 11 устанавливается в транспортном средстве и проецирует структурированный свет на поверхность дороги вокруг транспортного средства. Камера 12 устанавливается в транспортном средстве и является примером модуля захвата изображений, выполненного с возможностью захватывать и за счет этого получать изображения поверхности дороги вокруг транспортного средства, в том числе и области, на которую проецируется структурированный свет. ECU 13 является примером модуля управления, выполненного с возможностью управлять световым проектором 11 и выполнять последовательность циклов обработки информации для вычисления собственного местоположения транспортного средства из изображений, полученных посредством камеры 12.

[0010] Камера 12 представляет собой цифровую камеру с использованием полупроводникового датчика изображений, такого как CCD и CMOS, и получает цифровые изображения, которые допускают обработку изображений. То, что захватывает камера 12, представляет собой поверхность дороги вокруг транспортного средства. Поверхность дороги вокруг транспортного средства включает в себя поверхности дороги впереди, сзади, по бокам и под транспортным средством. Как показано на фиг.2, камера 12 может устанавливаться в передней секции транспортного средства 10, более конкретно, например, над передним бампером. Высота и направление, в которых устанавливается камера 12, регулируются таким способом, который позволяет камере 12 захватывать изображения характерных точек (текстур) на поверхности 31 дороги перед транспортным средством 10 и структурированного света 32b, проецируемого из светового проектора 11. Фокус и диафрагма линзы камеры 12 также регулируются автоматически. Камера 12 многократно захватывает изображения с предварительно определенными временными интервалами и за счет этого получает последовательность групп изображений (кадров). Каждый раз, когда камера 12 захватывает изображение, данные изображений, полученные с помощью камеры 12, передаются в ECU 13 и сохраняются в запоминающем устройстве, включенном в ECU 13.

[0011] Как показано на фиг.2, световой проектор 11 проецирует структурированный свет 32b, имеющий предварительно определенную форму, в том числе квадратного или прямоугольного решетчатого изображения, на поверхность 31 дороги в диапазоне захвата изображений камеры 12. Камера 12 захватывает изображения структурированного света, проецируемого на поверхность 31 дороги. Световой проектор 11 включает в себя, например, лазерный указатель и дифракционную решетку. Дифракционная решетка дифрагирует лазерный луч, проецируемый из лазерного указателя. В силу этого, как показано на фиг.2-4, световой проектор 11 формирует структурированный свет (32b, 32a), который включает в себя несколько световых пятен, размещаемых в решетчатом изображении или матричной структуре. В примерах, показанных на фиг.3 и 4, световой проектор 11 формирует структурированный свет 32a, включающий в себя 5*7 световых пятен.

[0012] Возвращаясь к фиг.1, ECU 13 включает в себя CPU, запоминающее устройство и микроконтроллер, включающий в себя секцию ввода-вывода. Посредством выполнения предварительно установленных компьютерных программ, ECU 13 формирует несколько информационных процессоров, которые выступают в качестве устройства вычисления собственного местоположения. Для каждого изображения (кадра), ECU 13 многократно выполняет последовательность циклов обработки информации для вычисления собственного местоположения транспортного средства из изображений, полученных с помощью камеры 12. В этой связи, ECU 13 также может использоваться в качестве ECU для управления другими системами транспортного средства 10.

[0013] В этом отношении, несколько информационных процессоров включают в себя модуль 21 извлечения структурированного света, модуль 22 вычисления угла ориентации, модуль 23 обнаружения характерных точек, модуль 24 вычисления величины изменения ориентации, модуль 26 вычисления собственного местоположения, модуль 27 управления структурированным светом и модуль 30 определения состояний поверхности дороги. Модуль 24 вычисления величины изменения ориентации включает в себя модуль 23 обнаружения характерных точек.

[0014] Модуль 21 извлечения структурированного света считывает изображение, полученное посредством камеры 12, из запоминающего устройства и извлекает позицию структурированного света из этого изображения. Например, как показано на фиг.3(a), световой проектор 11 проецирует структурированный свет 32a, который включает в себя несколько световых пятен, размещаемых в матричной структуре, на поверхность 31 дороги, в то время как камера 12 обнаруживает структурированный свет 32a, отражаемый от поверхности 31 дороги. Модуль 21 извлечения структурированного света применяет процесс преобразования в двоичную форму к изображению, полученному посредством камеры 12, и за счет этого извлекает только изображение световых пятен Sp, как показано на фиг.4(a) и 4(b). После этого, как показано на фиг.4(c), модуль 21 извлечения структурированного света извлекает позицию структурированного света 32a посредством вычисления позиции He центра тяжести каждого светового пятна Sp, другими словами, координат (Uj, Vj) каждого светового пятна Sp в изображении. Координаты выражаются с использованием числа, назначаемого соответствующему пикселу в датчике изображений камеры 12. В случае если структурированный свет включает в себя 5*7 световых пятен Sp, j является натуральным числом, не меньшим 1, но не большим 35. Запоминающее устройство сохраняет координаты (Uj, Vj) светового пятна Sp в изображении в качестве данных по позиции структурированного света 32a.

[0015] Модуль 22 вычисления угла ориентации считывает данные по позиции структурированного света 32a из запоминающего устройства и вычисляет расстояние и угол ориентации транспортного средства 10 относительно поверхности 31 дороги из позиции структурированного света 32a в изображении, полученном посредством камеры 12. Например, как показано на фиг.3(a), с использованием принципа тригонометрических измерений, модуль 22 вычисления угла ориентации вычисляет позицию каждой области световых пятен на поверхности 31 дороги, в качестве позиции области световых пятен относительно камеры 12, из базовой длины Lb между световым проектором 11 и камерой 12, а также координат (Uj, Vj) каждого светового пятна в изображении. После этого, модуль 22 вычисления угла ориентации вычисляет уравнение плоскости поверхности 31 дороги, на которую проецируется структурированный свет 32a, другими словами, расстояние и угол ориентации (вектор нормали) камеры 12 относительно поверхности 31 дороги, из относительной позиции каждого светового пятна относительно камеры 12.

[0016] Следует отметить, что в варианте осуществления, расстояние и угол ориентации камеры 12 относительно поверхности 31 дороги вычисляются как пример расстояния и угла ориентации транспортного средства 10 относительно поверхности 31 дороги, поскольку позиция установки камеры 12 в транспортном средстве 10 и угол для захвата посредством камеры 12 изображений уже известны. Другими словами, расстояние между поверхностью 31 дороги и транспортным средством 10, а также угол ориентации транспортного средства 10 относительно поверхности 31 дороги могут получаться посредством вычисления расстояния и угла ориентации камеры 12 относительно поверхности 31 дороги.

[0017] Более конкретно, поскольку камера 12 и световой проектор 11 закрепляются на транспортном средстве 10, направление, в котором проецируется структурированный свет 32a, и расстояние (базовая длина Lb) между камерой 12 и световым проектором 11 уже известны. По этой причине, с использованием принципа тригонометрических измерений, модуль 22 вычисления угла ориентации допускает получение позиции каждой области световых пятен на поверхности 31 дороги, в качестве относительной позиции (Xj, Yj, Zj) каждого светового пятна относительно камеры 12, из координат (Uj, Vj) каждого светового пятна в изображении. В дальнейшем в этом документе, расстояние и угол ориентации камеры 12 относительно поверхности 31 дороги сокращенно называются "расстоянием и углом ориентации". Расстояние и угол ориентации, вычисленные посредством модуля 22 вычисления угла ориентации, сохраняются в запоминающем устройстве.

[0018] Следует отметить, что описание предоставляется для варианта осуществления, в котором расстояние и угол ориентации вычисляются в каждом цикле обработки информации. Тем не менее, как упомянуто ниже, когда модуль 30 определения состояний поверхности дороги определяет то, что состояние поверхности дороги изменяется вплоть до или больше порогового значения, модуль 22 вычисления угла ориентации прекращает вычисление расстояния и угла ориентации транспортного средства 10.

[0019] Кроме того, во многих случаях, относительная позиция (Xj, Yj, Zj) каждого светового пятна относительно камеры 12 не присутствует на идентичной плоскости. Это обусловлено тем, что относительная позиция каждого светового пятна изменяется согласно неровности асфальта поверхности 31 дороги. По этой причине, метод наименьших квадратов может использоваться для того, чтобы получать уравнение плоскости, которое делает наименьшей сумму квадратов ошибки по расстоянию каждого светового пятна. Данные по такому вычисленному расстоянию и углу ориентации используются посредством модуля 26 вычисления собственного местоположения, показанного на фиг.1.

[0020] Модуль 23 обнаружения характерных точек считывает изображение, полученное посредством камеры 12, из запоминающего устройства и обнаруживает характерные точки на поверхности 31 дороги из изображения, считываемого из запоминающего устройства. Чтобы обнаруживать характерные точки на поверхности 31 дороги, модуль 23 обнаружения характерных точек может использовать способ, описанный в работе D. G. Lowe "Distinctive Image Features from Scale-Invariant Keypoints", Int. J. Comput. Vis., издание 60, № 2, стр. 91-110, ноябрь 2000 года. В противном случае, модуль 23 обнаружения характерных точек может использовать способ, описанный в работе Kanazawa Yasushi, Kanatani Kenichi, "Detection of Feature Points for Computer Vision", IEICE Journal, издание 87, № 12, стр. 1043-1048, декабрь 2004 года.

[0021] Более конкретно, например, модуль 23 обнаружения характерных точек использует оператор Харриса или оператор SUSAN и обнаруживает такие точки, как вершины объекта, значения яркости которых существенно отличаются от окрестностей точек, в качестве характерных точек. Тем не менее, вместо этого, модуль 23 обнаружения характерных точек может использовать характерную величину по принципу SIFT (масштабно-инвариантного преобразования признаков), так что точки, вокруг которых значения яркости изменяются с определенной регулярностью, обнаруживаются в качестве характерных точек. Кроме того, модуль 23 обнаружения характерных точек подсчитывает общее число N характерных точек, обнаруженных из одного изображения, и назначает идентификационные номера (i (1≤i≤N)) соответствующим характерным точкам. Позиция (Ui, Vi) каждой характерной точки в изображении сохраняется в запоминающем устройстве в ECU 13. Фиг.6(a) и 6(b) показывают примеры характерных точек Te, которые обнаруживаются из изображения, захваченного посредством камеры 12. Кроме того, направления изменений каждой характерной точки Te и величины изменений каждой характерной точки Te выражаются с помощью векторов Dte.

[0022] Следует отметить, что в варианте осуществления, смесь частиц асфальта с размером частиц не менее 1 см, но не более 2 см, предполагается в качестве характерных точек на поверхности 31 дороги. Камера 12 использует режим VGA-разрешения (приблизительно 300 тысяч пикселов) для того, чтобы обнаруживать характерные точки. Помимо этого, расстояние камеры 12 относительно поверхности 31 дороги составляет приблизительно 70 см. Кроме того, направление, в котором камера 12 захватывает изображения, наклонено приблизительно под 45 градусами к поверхности 31 дороги от горизонтальной плоскости. Более того, значение яркости каждого изображения, захваченного посредством камеры 12 и после этого отправленного в ECU 13, находится в пределах диапазона от 0 до 255 (0: самое темное, 255: самое яркое).

[0023] Модуль 24 вычисления величины изменения ориентации считывает, из запоминающего устройства, позиционные координаты (Ui, Vi) нескольких характерных точек в изображении, включенном в предыдущий кадр с изображением (во время t), который находится в числе кадров с изображениями, захваченных в каждом определенном цикле обработки информации. Кроме того, модуль 24 вычисления величины изменения ориентации считывает, из запоминающего устройства, позиционные координаты (Ui, Vi) нескольких характерных точек в изображении, включенном в изображение текущего кадра (во время t+Δt). После этого, на основе временных изменений позиций нескольких характерных точек в изображении, модуль 24 вычисления величины изменения ориентации получает величину изменения ориентации транспортного средства. В этом отношении, величина изменения ориентации транспортного средства включает в себя как "величины изменений расстояния и угла ориентации" транспортного средства относительно поверхности дороги, так и "величину перемещения транспортного средства" на поверхности дороги. Ниже предоставляется описание того, как вычислять "величины изменений расстояния и угла ориентации" и "величину перемещения транспортного средства".

[0024] Величины изменений расстояния и угла ориентации могут получаться, например, следующим образом. Фиг.6(a) показывает пример первого кадра 38 (изображения) (на фиг.5), захваченного во время t. Допустим случай, в котором, как показано на фиг.5 и 6(a), относительная позиция (Xi, Yi, Zi) каждой из трех характерных точек Te1, Te2, Te3 вычисляется, например, в первом кадре 38. В этом случае, плоскость G (см. фиг.6(a)), идентифицированная посредством характерных точек Te1, Te2, Te3, может рассматриваться в качестве поверхности дороги. Соответственно, модуль 24 вычисления величины изменения ориентации допускает получение расстояния и угла ориентации (вектора нормали) камеры 12 относительно поверхности дороги (плоскости G) из относительной позиции (Xi, Yi, Zi) каждой из характерных точек. Кроме того, из уже известной модели камеры, модуль 24 вычисления величины изменения ориентации допускает получение расстояния l1, l2, l3 между каждой характерной точкой Te1, Te2, Te3, а также угла между прямыми линиями, соединяющими каждую характерную точку Te1, Te2, Te3. Камера 12 на фиг.5 показывает позицию камеры, когда захватывается первый кадр.

[0025] Следует отметить, что на фиг.5, трехмерные координаты (Xi, Yi, Zi) относительной позиции каждой характерной точки относительно камеры 12 задаются таким способом, что: ось Z совпадает с направлением, в котором камера 12 захватывает изображение; и оси X и Y, ортогональные друг к другу в плоскости, включающей в себя камеру 12, представляют собой линии, нормальные к направлению, в котором камера 12 захватывает изображение. Между тем, координаты в изображении 38 задаются таким образом, что: ось V совпадает с горизонтальным направлением; и ось U совпадает с вертикальным направлением.

[0026] Фиг.6(b) показывает второй кадр 38', полученный во время (t+Δt), в которое продолжительность Δt истекла со времени t. Камера 12' на фиг.5 показывает позицию камеры, когда камера захватывает второй кадр 38'. Как показано на фиг.5 и 6(b), камера 12' захватывает изображение, включающее в себя характерные точки Te1, Te2, Te3, в качестве второго кадра 38', и модуль 23 обнаружения характерных точек обнаруживает характерные точки Te1, Te2, Te3 из изображения. В этом случае, модуль 24 вычисления величины изменения ориентации допускает вычисление величины ΔL перемещения камеры 12 в интервале Δt времени из: относительной позиции (Xi, Yi, Zi) каждой из характерных точек Te1, Te2, Te3 во время t; позиции P1(Ui, Vi) каждой характерной точки на втором кадре 38'; и модели камеры для камеры 12. Соответственно, модуль 24 вычисления величины изменения ориентации допускает вычисление величины перемещения транспортного средства. Кроме того, модуль 24 вычисления величины изменения ориентации также допускает вычисление величин изменений расстояния и угла ориентации. Например, модуль 24 вычисления величины изменения ориентации допускает вычисление величины (ΔL) перемещения камеры 12 (транспортного средства) и величин изменений расстояния и угла ориентации камеры 12 (транспортного средства) посредством решения следующей системы уравнений (1)-(4). В этой связи, уравнение (1), приведенное ниже, основано на идеальной камере с точечной диафрагмой без деформации и оптического осевого рассогласования, которая моделируется после камеры 12, где λi и f обозначают константу и фокусную длину. Параметры модели камеры могут калиброваться заранее.

[0027] уравнение 1

...(1)

[0028] уравнение 2

...(2)

[0029] уравнение 3

...(3)

[0030] уравнение 4

...(4)

[0031] Следует отметить, что вместо использования всех характерных точек, относительные позиции которых вычисляются в изображениях, обнаруженных во время t и во время t+Δt, модуль 24 вычисления величины изменения ориентации может выбирать оптимальные характерные точки на основе позиционных взаимосвязей между характерными точками. Пример способа выбора, применимого для этой цели, представляет собой эпиполярную геометрию (геометрию эпиполярных линий, описанную в работе R. I. Hartley "A linear method for reconstruction from lines and points", Proc. 5th International Conference on Computer Vision, Кембридж, штат Массачусетс, стр. 882-887 (1995)).

[0032] Если как в этом случае, характерные точки Te1, Te2, Te3, относительные позиции которых в кадровом изображении 38 во время t вычисляются, также обнаруживаются посредством модуля 23 обнаружения характерных точек из кадрового изображения 38' во время t+Δt, модуль 24 вычисления величины изменения ориентации допускает вычисление "величины изменения угла ориентации транспортного средства" из временных изменений относительных позиций (Xi, Yi, Zi) соответствующих характерных точек на поверхности дороги и временных изменений позиций (Ui, Vi) соответствующих характерных точек в изображении. Кроме того, модуль 24 вычисления величины изменения ориентации допускает вычисление величины перемещения транспортного средства.

[0033] Более конкретно, если три или более характерных точек, имеющих отношение соответствия между предыдущим кадром и текущим кадром, могут обнаруживаться непрерывно, продолжение процесса (операции интегрирования) суммирования величин изменений расстояния и угла ориентации позволяет непрерывно обновлять расстояние и угол ориентации без использования структурированного света 32a. Тем не менее, расстояние и угол ориентации, вычисленные с использованием структурированного света 32a либо предварительно определенного начального расстояния и начального угла ориентации, могут использоваться для первого цикла обработки информации. Другими словами, расстояние и угол ориентации, которые являются начальными точками операции интегрирования, могут вычисляться с использованием структурированного света 32a или могут использовать предварительно определенные начальные значения. Желательно, если предварительно определенное начальное расстояние и предварительно определенный начальный угол ориентации представляют собой расстояние и угол ориентации, определенные, по меньшей мере, с учетом пассажиров и рабочей нагрузки транспортного средства 10. Например, расстояние и угол ориентации, вычисленные с использованием структурированного света 32a, который проецируется в то время, когда переключатель зажигания транспортного средства 10 включен, и когда позиция переключения коробки передач перемещается из позиции для парковки в другую позицию, могут использоваться в качестве предварительно определенного начального расстояния и начального угла ориентации. В силу этого, можно получать расстояние и угол ориентации, которые не затрагиваются посредством перемещения по крену или перемещения с наклоном в продольном направлении вследствие поворота, ускорения или замедления транспортного средства 10.

[0034] Следует отметить, что ассоциирование характерных точек в текущем кадре с характерными точками в предыдущем кадре может достигаться, например, посредством: сохранения изображения небольшой области вокруг каждой обнаруженной характерной точки в запоминающем устройстве; и для каждой характерной точки, выполнения определения из подобия в информации яркости и цветов. Более конкретно, ECU 13 сохраняет 5 (по горизонтали) * 5 (по вертикали)-пикселное изображение вокруг каждой обнаруженной характерной точки в запоминающем устройстве. Если, например, ошибка в информации яркости, имеющей 20 или более пикселов, равна или меньше 1%, модуль 24 вычисления величины изменения ориентации определяет то, что рассматриваемые характерные точки соответствуют промежутку между текущим и предыдущим кадрами. После этого, величина изменения ориентации, полученная посредством вышеприведенного процесса, используется посредством модуля 25 вычисления собственного местоположения на следующем этапе процесса для того, чтобы вычислять собственное местоположение транспортного средства 10.

[0035] Модуль 26 вычисления собственного местоположения вычисляет текущее расстояние и угол ориентации транспортного средства 10 из "величин изменений расстояния и угла ориентации", вычисленных посредством модуля 24 вычисления величины изменения ориентации. Помимо этого, модуль 26 вычисления собственного местоположения вычисляет собственное местоположение транспортного средства 10 из "величины перемещения транспортного средства", вычисленной посредством модуля 24 вычисления величины изменения ориентации.

[0036] Ниже предоставляется описание того, как выполнять вышеприведенные вычисления в конкретном случае, в котором расстояние и угол ориентации, вычисленные посредством модуля 22 вычисления угла ориентации (другими словами, расстояние и угол ориентации, вычисленные с использованием структурированного света), задаются в качестве начальных точек вычислений. В этом случае, модуль 26 вычисления собственного местоположения обновляет расстояние и угол ориентации с последними числовыми значениями посредством последовательного суммирования (выполнения операции интегрирования) величин изменений расстояния и угла ориентации, вычисленных для каждого кадра посредством модуля 24 вычисления величины изменения ориентации, с начальными точками, другими словами, с расстоянием и углом ориентации, вычисленными посредством модуля 22 вычисления угла ориентации. Помимо этого, модуль 26 вычисления собственного местоположения вычисляет собственное местоположение транспортного средства посредством: задания позиции транспортного средства, которая получается, когда модуль 22 вычисления угла ориентации вычисляет расстояние и угол ориентации, в качестве начальной точки (начальной позиции транспортного средства); и посредством последовательного суммирования (выполнения операции интегрирования) величины перемещения транспортного средства из начальной позиции транспортного средства. Например, посредством задания начальной точки (начальной позиции транспортного средства), которая совпадает с позицией на карте, модуль 26 вычисления собственного местоположения допускает последовательное вычисление текущего собственного местоположения транспортного средства на карте.

[0037] В силу этого, модуль 24 вычисления величины изменения ориентации допускает вычисление собственного местоположения транспортного средства посредством получения величины (ΔL) перемещения камеры 12 для продолжительности Δt. Помимо этого, модуль 24 вычисления величины изменения ориентации допускает одновременное вычисление величин изменений расстояния и угла ориентации. По этим причинам, с учетом величин изменений расстояния и угла ориентации транспортного средства, модуль 24 вычисления величины изменения ориентации допускает точное вычисление величины (ΔL) перемещения с шестью степенями свободы (перемещение вперед/назад, перемещение влево/вправо, перемещение вверх/вниз, перемещение относительно вертикальной оси, наклон в продольном направлении и крен). Другими словами, ошибка в оценке величины (ΔL) перемещения может быть минимизирована, даже если расстояние и угол ориентации изменяются посредством перемещения по крену или перемещения с наклоном в продольном направлении вследствие поворота, ускорения или замедления транспортного средства 10.

[0038] В варианте осуществления, величина (ΔL) перемещения камеры 12 вычисляется посредством: вычисления величин изменений расстояния и угла ориентации; и обновления расстояния и угла ориентации. Тем не менее, вместо этого, величина (ΔL) перемещения камеры 12 может вычисляться посредством: вычисления величины изменения только угла ориентации камеры 12 относительно поверхности 31 дороги; и обновления только угла ориентации камеры 12. В этом случае, можно предполагать, что расстояние между поверхностью 31 дороги и камерой 12 остается постоянным. Это позволяет уменьшать рабочую нагрузку на ECU 13 при минимизации ошибки в оценке величины (ΔL) перемещения с учетом величины изменения угла ориентации и повышать скорость работы ECU 13.

[0039] Модуль 27 управления структурированным светом управляет проецированием структурированного света 32a посредством светового проектора 11. Например, когда переключатель зажигания транспортного средства 10 включается, и устройство вычисления собственного местоположения становится активированным, модуль 27 управления структурированным светом одновременно начинает проецировать структурированный свет 32a. После этого, до тех пор, пока устройство вычисления собственного местоположения не прекратит работу, модуль 27 управления структурированным светом продолжает проецирование структурированного света 32a. В противном случае, модуль 27 управления структурированным светом может попеременно включать и выключать проецирование света с предварительно определенными интервалами.

[0040] Модуль 30 определения состояний поверхности дороги обнаруживает изменения состояния поверхности дороги вокруг транспортного средства и определяет то, изменяется либо нет состояние поверхности дороги вплоть до или больше порогового значения. Если модуль 30 определения состояний поверхности дороги определяет то, что состояние поверхности дороги изменяется вплоть до или больше порогового значения, модуль 26 вычисления собственного местоположения задает начальные точки фиксированно равными текущей позиции транспортного средства 10, а также текущему расстоянию и углу ориентации транспортного средства 10 относительно поверхности дороги, которые вычисляются в предыдущем цикле обработки информации. В силу этого, модуль 22 вычисления угла ориентации прекращает вычисление расстояния и угла ориентации транспортного средства 10 относительно поверхности дороги. Между тем, модуль 26 вычисления собственного местоположения вычисляет текущую позицию транспортного средства в данный момент, а также текущее расстояние и угол ориентации транспортного средства 10 относительно поверхности дороги, посредством суммирования величины изменения ориентации с текущей позицией транспортного средства 10, а также с текущим расстоянием и углом ориентации транспортного средства 10 относительно поверхности дороги, которые вычисляются в предыдущем цикле обработки информации.

[0041] В этом отношении, ниже предоставляется описание того, как определять изменения состояния поверхности дороги. В этом варианте осуществления, 35 (5*7) световых пятен структурированного света 32a проецируются на поверхности дороги. Таким образом, например, если только 80% или меньше из 35 световых пятен или только 28 или меньше световых пятен могут обнаруживаться в изображении, захваченном посредством камеры 12, модуль 30 определения состояний поверхности дороги определяет то, что: поверхность дороги становится очень неровной или ухабистой; и состояние поверхности дороги изменяется вплоть до или больше порогового значения.

[0042] Вместо этого, модуль 30 определения состояний поверхности дороги может оценивать изменения состояния поверхности дороги из величины изменений высот поверхности дороги. Величина изменений высот поверхности дороги может обнаруживаться из колебаний значения, обнаруженного посредством датчика хода, присоединяемого к подвеске каждого колеса транспортного средства. Например, если колебания значения, обнаруженного посредством датчика хода, становятся равными или превышающими 1 Гц, модуль 30 определения состояний поверхности дороги оценивает то, что поверхность дороги становится очень неровной или ухабистой, и определяет то, что состояние поверхности дороги изменяется вплоть до или больше порогового значения. Альтернативно, модуль 30 определения состояний поверхности дороги может быть