Решение относительно наличия/отсутствия вокализации для обработки речи

Иллюстрации

Показать всеИзобретение относится к решению относительно наличия/отсутствия вокализации для обработки речи. Технический результат заключается в усовершенствованном и более надежном обнаружении невокализованной/вокализованной речи. Способ обработки речи включает этапы: определение параметра наличия/отсутствия вокализации в текущем кадре речевого сигнала, который является комбинированным параметром, отражающим произведение параметра периодичности и параметра спектрального наклона; определение сглаженного параметра наличия/отсутствия вокализации для включения информации параметра наличия/отсутствия вокализации в предшествующий кадр; вычисление разности между параметром наличия/отсутствия вокализации в текущем кадре и сглаженным параметром и определение, содержит ли текущий кадр невокализованную речь или вокализованную речь, с использованием вычисленной разности в качестве параметра принятия решения. 2 н. и 18 з.п. ф-лы, 15 ил.

Реферат

ОБЛАСТЬ ТЕХНИКИ, К КОТОРОЙ ОТНОСИТСЯ ИЗОБРЕТЕНИЕ

[0001] Настоящее изобретение, в целом, относится к области обработки речи и, в частности, к решению относительно наличия/отсутствия вокализации для обработки речи.

УРОВЕНЬ ТЕХНИКИ

[0002] Кодирование речи означает процесс, который снижает битовую скорость речевого файла. Кодирование речи это применение сжатия данных цифровых аудиосигналов, содержащих речь. Кодирование речи использует оценивание речевого параметра с использованием методов обработки аудиосигнала для моделирования речевого сигнала, объединенное с алгоритмами общего сжатия данных, для представления полученных смоделированных параметров в компактном битовом потоке. Задачей кодирования речи является достижение экономии необходимого объема памяти, полосы передачи и мощности передачи путем уменьшения количества битов для каждой выборки, чтобы декодированную (восстановленную после сжатия) речь невозможно было отличить на слух от исходной речи.

[0003] Однако речевые кодеры являются кодерами с потерями, т.е. декодированный сигнал отличается от исходного. Таким образом, одной из целей кодирования речи является минимизация искажений (или воспринимаемых потерь) при данной битовой скорости или минимизация битовой скорости для достижения данного уровня искажений.

[0004] Кодирование речи отличается от других форм аудиокодирования тем, что речь является значительно более простым сигналом, чем большинство других аудиосигналов, и доступно гораздо больше статистической информации о свойствах речи. В результате, некоторая звуковая информация, значимая в аудиокодировании, может быть не нужна в контексте кодирования речи. В кодировании речи, наиболее важным критерием является сохранение разборчивости и "приятности" речи при ограниченном объеме передаваемых данных.

[0005] Разборчивость речи включает в себя, помимо фактического буквального содержания, также личность, эмоции, интонацию, тембр и т.д. говорящего, которые все важны для высокой разборчивости. Более абстрактное понятие приятности искаженного речевого сигнала является другим свойством, чем разборчивость, поскольку возможно, что искаженный речевой сигнал полностью разборчив, но субъективно раздражает слушателя.

[0006] Избыточность форм волны речи можно рассматривать в отношении нескольких разных типов речевого сигнала, например, вокализованного и невокализованного речевых сигналов. Вокализованные звуки, например, ‘а’, ‘б’, по существу, обусловлены вибрациями голосовых связок и являются колебательными. Таким образом, в течение коротких периодов времени, они успешно моделируются суммами периодических сигналов, например синусоид. Другими словами, для вокализованной речи, речевой сигнал является, по существу, периодическим. Однако эта периодичность может изменяться в течение длительности речевого сегмента, и форма периодической волны обычно изменяется постепенно от сегмента к сегменту. Кодирование речи с низкой битовой скоростью может извлекать большое преимущество из исследования такой периодичности. Период вокализованной речи также называется основным тоном, и прогнозирование основного тона часто именуется долгосрочным прогнозированием (LTP). Напротив, невокализованные звуки, например, ‘с’, ‘ш’, являются более шумоподобными. Дело в том, что невокализованный речевой сигнал, более вероятно, является случайным шумом и имеет меньшую степень прогнозируемости.

[0007] Традиционно, все способы параметрического кодирования речи используют избыточность, присущую речевому сигналу для снижения объема информации, которую нужно отправлять, и для оценивания параметров речевых выборок сигнала с короткими интервалами. Эта избыточность, в основном, обусловлена повторением форм волны речи с квазипериодической частотой, и медленным изменением спектральной огибающей речевого сигнала.

[0008] Избыточность форм волны речи можно рассматривать в отношении нескольких разных типов речевого сигнала, например, вокализованного и невокализованного. Хотя речевой сигнал является, по существу, периодическим для вокализованной речи, эта периодичность может изменяться в течение длительности речевого сегмента, и форма периодической волны обычно изменяется постепенно от сегмента к сегменту. Кодирование речи с низкой битовой скоростью может извлекать большое преимущество из исследования такой периодичности. Период вокализованной речи также называется основным тоном, и прогнозирование основного тона часто именуется долгосрочным прогнозированием (LTP). Что касается невокализованной речи, сигнал, более вероятно, является случайным шумом и имеет меньшую степень прогнозируемости.

[0009] В любом случае, параметрическое кодирование может использоваться для снижения избыточности речевых сегментов путем отделения компоненты возбуждения речевого сигнала от компоненты спектральной огибающей. Медленно изменяющуюся спектральную огибающую можно представить посредством кодирования с линейным прогнозированием (LPC), также именуемого краткосрочным прогнозированием (STP). Кодирование речи с низкой битовой скоростью также может пользоваться большим преимуществом исследования такого краткосрочного прогнозирования. Преимущество кодирования обусловлено низкой скоростью изменения параметров. Кроме того, параметры редко значительно отличаются от значений, поддерживаемых в течение нескольких миллисекунд. Соответственно, при частоте дискретизации 8 кГц, 12.8 кГц или 16 кГц, алгоритм кодирования речи предусматривает номинальную длительность кадра в пределах от десяти до тридцати миллисекунд. Чаще всего, длительность кадра составляет двадцать миллисекунд.

[0010] В более недавних общеизвестных стандартах применяются, например, G.723.1, G.729, G.718, Enhanced Full Rate (EFR), Selectable Mode Vocoder (SMV), Adaptive Multi-Rate (AMR), Variable-Rate Multimode Wideband (VMR-WB) или Adaptive Multi-Rate Wideband (AMR-WB), Code Excited Linear Prediction Technique ("CELP"). Под CELP обычно понимают техническую комбинацию кодированного возбуждения, долгосрочного прогнозирования и краткосрочного прогнозирования. CELP в основном, используется для кодирования речевого сигнала на основе конкретных характеристик человеческого голоса или модели генерации человеческого голоса. Кодирование речи CELP является очень популярным алгоритмом в области сжатия речи, хотя детали CELP для разных кодеков могут значительно отличаться. Благодаря своей популярности, алгоритм CELP использовался в различных стандартах ITU-T, MPEG, 3GPP и 3GPP2. Варианты CELP включают в себя алгебраическое CELP, ослабленное CELP, CELP низкой задержки и линейное прогнозирование с возбуждением векторной суммой и пр.. CELP является общим термином для класса алгоритмов, но не для конкретного кодека.

[0011] Алгоритм CELP базируется на четырех основных принципах. Во-первых, используется модель источника-фильтра генерации речи посредством линейного прогнозирования (LP). Модель источника-фильтра генерации речи моделирует речь в виде комбинации источника звука, например, голосовых связок, и линейного акустического фильтра, речевого тракта (и характеристики излучения). В реализации модели источника-фильтра генерации речи, источник звука, или сигнал возбуждения, часто моделируется как периодическая последовательность импульсов, для вокализованной речи, или белый шум для невокализованной речи. Во-вторых, адаптивная и фиксированная кодовая книга используется в качестве входа (возбуждения) модели LP. В-третьих, поиск осуществляется с обратной связью в “перцепционно взвешенной области”. В-четвертых, применяется векторное квантование (VQ).

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0012] В соответствии с вариантом осуществления настоящего изобретения, способ обработки речи содержит определение параметра наличия/отсутствия вокализации, отражающего характеристику невокализованной/вокализованной речи в текущем кадре речевого сигнала, содержащего множество кадров. Сглаженный параметр наличия/отсутствия вокализации определяется для включения информации параметра наличия/отсутствия вокализации в кадр, предшествующий текущему кадру речевого сигнала. Вычисляется разность между параметром наличия/отсутствия вокализации и сглаженным параметром наличия/отсутствия вокализации. Способ дополнительно включает в себя генерацию точки принятия решения относительно наличия/отсутствия вокализации для определения, содержит ли текущий кадр невокализованную речь или вокализованную речь, с использованием вычисленной разности в качестве параметра принятия решения.

[0013] В альтернативном варианте осуществления, устройство обработки речи содержит процессор и компьютерно-считываемый носитель данных, где хранится программное обеспечение, исполняемое процессором. Программное обеспечение включает в себя инструкции для определения параметра наличия/отсутствия вокализации, отражающего характеристику невокализованной/вокализованной речи в текущем кадре речевого сигнала, содержащего множество кадров, и определения сглаженного параметра наличия/отсутствия вокализации для включения информации параметра наличия/отсутствия вокализации в кадр, предшествующий текущему кадру речевого сигнала. Программное обеспечение дополнительно включает в себя инструкции для вычисления разности между параметром наличия/отсутствия вокализации и сглаженным параметром наличия/отсутствия вокализации, и генерации точки принятия решения относительно наличия/отсутствия вокализации для определения, содержит ли текущий кадр невокализованную речь или вокализованную речь, с использованием вычисленной разности в качестве параметра принятия решения.

[0014] В альтернативном варианте осуществления, способ обработки речи содержит обеспечение множества кадров речевого сигнала и определение, для текущего кадра, первого параметра для первого частотного диапазона из первой энергетической огибающей речевого сигнала во временной области и второго параметра для второго частотного диапазона из второй энергетической огибающей речевого сигнала во временной области. Сглаженный первый параметр и сглаженный второй параметр определяются из предыдущих кадров речевого сигнала. Первый параметр сравнивается со сглаженным первым параметром, и второй параметр сравнивается со сглаженным вторым параметром. Точка принятия решения относительно наличия/отсутствия вокализации генерируется для определения, содержит ли текущий кадр невокализованную речь или вокализованную речь, с использованием сравнения в качестве параметра принятия решения.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

[0015] Для более полного понимания настоящего изобретения и его преимуществ, ниже приведены описания совместно с прилагаемыми чертежами, в которых:

[0016] фиг. 1 иллюстрирует оценивание энергии во временной области речевого сигнала низкочастотного диапазона в соответствии с вариантами осуществления настоящего изобретения;

[0017] фиг. 2 иллюстрирует оценивание энергии во временной области речевого сигнала высокочастотного диапазона в соответствии с вариантами осуществления настоящего изобретения;

[0018] фиг. 3 иллюстрирует операции, осуществляемые в ходе кодирования исходной речи с использованием традиционного кодера CELP, реализующего вариант осуществления настоящего изобретения.

[0019] фиг. 4 иллюстрирует операции, осуществляемые в ходе декодирования исходной речи с использованием традиционного декодера CELP, реализующего вариант осуществления настоящего изобретения;

[0020] фиг. 5 иллюстрирует традиционный кодер CELP, используемый в реализации вариантов осуществления настоящего изобретения;

[0021] фиг. 6 иллюстрирует базовый декодер CELP, соответствующий кодеру, показанному на фиг. 5, в соответствии с вариантом осуществления настоящего изобретения;

[0022] фиг. 7 иллюстрирует шумоподобные векторы-кандидаты для построения кодовой книги кодированного возбуждения или фиксированной кодовой книги кодирования речи CELP;

[0023] фиг. 8 иллюстрирует импульсоподобные векторы-кандидаты для построения кодовой книги кодированного возбуждения или фиксированной кодовой книги кодирования речи CELP;

[0024] фиг. 9 иллюстрирует пример спектра возбуждения для вокализованной речи;

[0025] фиг. 10 иллюстрирует пример спектра возбуждения для невокализованной речи;

[0026] фиг. 11 иллюстрирует пример спектра возбуждения для сигнала фонового шума;

[0027] фиг. 12A и 12B иллюстрируют примеры кодирования/декодирования в частотной области с расширением полосы, в которых фиг. 12A иллюстрирует кодер с информацией стороны BWE, тогда как фиг. 12B иллюстрирует декодер с BWE;

[0028] фиг. 13A-13C описывают операции обработки речи в соответствии с различными вышеописанными вариантами осуществления;

[0029] фиг. 14 иллюстрирует систему 10 связи согласно варианту осуществления настоящего изобретения; и

[0030] фиг. 15 демонстрирует блок-схему системы обработки, которая может использоваться для реализации раскрытых здесь устройств и способов.

ПОДРОБНОЕ ОПИСАНИЕ ИЛЛЮСТРАТИВНЫХ ВАРИАНТОВ ОСУЩЕСТВЛЕНИЯ

[0031] В современной системе передачи цифрового аудио/речевого сигнала, цифровой сигнал сжимается на кодере, и сжатая информация или битовый поток может покадрово пакетизироваться и отправляться на декодер по каналу связи. Декодер принимает и декодирует сжатую информацию для получения цифрового аудио/речевого сигнала.

[0032] Для более эффективного кодирования речевого сигнала, речевой сигнал можно классифицировать на разные классы, и каждый класс кодируется по-разному. Например, в некоторых стандартах, например, G.718, VMR-WB или AMR-WB, речевой сигнал подразделяется на невокализованный, переходный, общий, вокализованный и шумовой.

[0033] Вокализованный речевой сигнал является сигнальном квазипериодического типа, который обычно имеет более высокую энергию в низкочастотной области, чем в высокочастотной области. Напротив, невокализованный речевой сигнал является шумоподобным сигналом, который обычно имеет более высокую энергию в высокочастотной области, чем в низкочастотной области. Классификация по наличию/отсутствию вокализации или решение относительно отсутствия вокализации широко используется в области кодирования речевого сигнала, расширения полосы речевого сигнала (BWE), улучшения речевого сигнала и снижения фонового шума речевого сигнала (NR).

[0034] В кодировании речи, невокализованный речевой сигнал и вокализованный речевой сигнал могут кодироваться/декодироваться по-разному. В расширении полосы речевого сигнала, энергия расширенного высокополосного сигнала невокализованного речевого сигнала может управляться иначе, чем энергия вокализованного речевого сигнала. В снижении фонового шума речевого сигнала, алгоритм NR может различаться для невокализованного речевого сигнала и вокализованного речевого сигнала. Поэтому достоверное решение относительно отсутствия вокализации важно для вышеупомянутых видов применений.

[0035] Варианты осуществления настоящего изобретения повышают точность классификации аудиосигнала как вокализованного сигнала или невокализованного сигнала до операций кодирования речи, расширения полосы и/или улучшения речи. Таким образом, варианты осуществления настоящего изобретения могут применяться к кодированию речевого сигнала, расширению полосы речевого сигнала, улучшению речевого сигнала и снижению фонового шума речевого сигнала. В частности, варианты осуществления настоящего изобретения могут использоваться для улучшения стандарта речевого кодера AMR-WB ITU-T в расширении полосы.

[0036] Иллюстрация характеристик речевого сигнала, используемых для повышения точности классификации аудиосигнала на вокализованный сигнал или невокализованный сигнал в соответствии с вариантами осуществления настоящего изобретения будет проиллюстрирована с использованием фиг. 1 и 2. Речевой сигнал оценивается в двух режимах: низкочастотном диапазоне и высокочастотном диапазоне в нижеследующих иллюстрациях.

[0037] Фиг. 1 иллюстрирует оценивание энергии во временной области речевого сигнала низкочастотного диапазона в соответствии с вариантами осуществления настоящего изобретения.

[0038] Энергетическая огибающая 1101 во временной области речь низкочастотного диапазона является сглаженной по времени энергетической огибающей и включает в себя первую область 1102 фонового шума и вторую область 1105 фонового шума, разделенные областями 1103 невокализованной речи и областью 1104 вокализованной речи. Низкочастотный вокализованный речевой сигнал области 1104 вокализованной речи имеет более высокую энергию, чем низкочастотный невокализованный речевой сигнал в областях 1103 невокализованной речи. Дополнительно, низкочастотный невокализованный речевой сигнал имеет более высокую или более близкую энергию по сравнению с низкочастотным сигналом фонового шума.

[0039] Фиг. 2 иллюстрирует оценивание энергии во временной области речевого сигнала высокочастотного диапазона в соответствии с вариантами осуществления настоящего изобретения.

[0040] В отличие от фиг. 1, высокочастотный речевой сигнал имеет другие характеристики. Энергетическая огибающая во временной области высокополосного речевого сигнала 1201, которая является сглаженной по времени энергетической огибающей, включает в себя первую область 1202 фонового шума и вторую область 1205 фонового шума, разделенные областями 1203 невокализованной речи и областью 1204 вокализованной речи. Высокочастотный вокализованный речевой сигнал имеет более низкую энергию, чем высокочастотный невокализованный речевой сигнал. Высокочастотный невокализованный речевой сигнал имеет значительно более высокую энергию по сравнению с высокочастотным сигналом фонового шума. Однако высокочастотный невокализованный речевой сигнал 1203 имеет сравнительно меньшую длительность, чем вокализованная речь 1204.

[0041] Варианты осуществления настоящего изобретения опираются на это различие в характеристики между вокализованной и невокализованной речью в разных частотных диапазонах во временной области. Например, сигнал в текущем кадре можно идентифицировать как вокализованный сигнал путем определения, что энергия сигнала выше, чем у соответствующего невокализованного сигнала в полосе низких частот, но не в полосе высоких частот. Аналогично, сигнал в текущем кадре можно идентифицировать как невокализованный сигнал путем идентификации, что энергия сигнала ниже, чем у соответствующего вокализованного сигнала в полосе низких частот, но выше, чем у соответствующего вокализованного сигнала в полосе высоких частот.

[0042] Традиционно, для обнаружения невокализованного/вокализованного речевого сигнала используются два главных параметра. Один параметр представляет периодичность сигнала, и другой параметр указывает спектральный наклон, который выражает, насколько падает интенсивность с ростом частота.

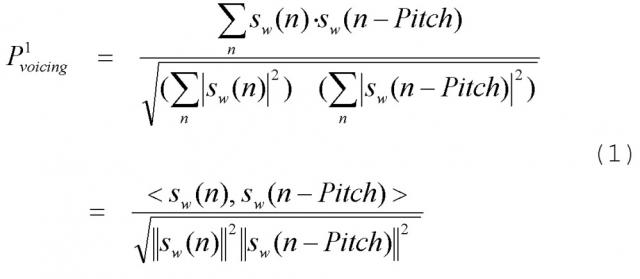

[0043] Популярный параметр периодичности сигнала обеспечен ниже в уравнении (1).

В уравнении (1), - взвешенный речевой сигнал, числитель выражает корреляцию, и знаменатель - коэффициент нормализации энергии. Параметр периодичности также называется “корреляцией основного тона” или “вокализацией”. Другой пример параметр вокализации обеспечен ниже в уравнении (2).

В (2), - сигналы компонент возбуждения и будут дополнительно описаны ниже. В различных применениях, можно использовать некоторые варианты уравнений (1) и (2), но все же они могут представлять периодичность сигнала.

[0044] Наиболее популярный параметр спектрального наклона обеспечен ниже в уравнении (3).

В уравнении (3), s(n) - речевой сигнал. Если доступна энергия в частотной области, параметр спектрального наклона можно выразить в уравнении (4).

В уравнении (4), ELB - энергия низкочастотного диапазона, и EHB - энергия высокочастотного диапазона.

[0045] Другой параметр, который может отражать спектральный наклон, называется частота прохождения через нуль (ZCR). ZCR показывает, сколько раз сигнал меняет знак на протяжении кадра или подкадра. Обычно, когда энергия высокочастотного диапазона высока относительно энергии низкочастотного диапазона, ZCR также высока. В противном случае, когда энергия высокочастотного диапазона низка относительно энергии низкочастотного диапазона, ZCR также низка. В реальных применениях могут использоваться некоторые варианты уравнений (3) и (4), но все же они могут представлять спектральный наклон.

[0046] Как упомянуто ранее, классификация по наличию/отсутствию вокализации или решение относительно наличия/отсутствия вокализации широко используется в области кодирования речевого сигнала, расширения полосы речевого сигнала (BWE), улучшения речевого сигнала и снижения фонового шума речевого сигнала (NR).

[0047] В кодировании речи, невокализованный речевой сигнал можно кодировать с использованием шумоподобного возбуждения, и вокализованный речевой сигнал можно кодировать с использованием импульсоподобного возбуждения, как будет проиллюстрировано ниже. В расширении полосы речевого сигнала, энергия расширенного высокополосного сигнала невокализованного речевого сигнала может увеличиваться, тогда как энергия расширенного высокополосного сигнала вокализованного речевого сигнала может снижаться. В снижении фонового шума речевого сигнала (NR), алгоритм NR может быть менее агрессивным для невокализованного речевого сигнала и более агрессивным для вокализованного речевого сигнала. Поэтому достоверное решение о наличии/отсутствии вокализации важно для вышеупомянутых видов применений. На основании характеристик невокализованной речи и вокализованной речи, параметр периодичности Pvoicing и параметр спектрального наклона Ptilt или их варианты по большей части используются для обнаружения невокализованных/вокализованных классов. Однако авторы данной заявки установили, что “абсолютные” значения параметра периодичности Pvoicing и параметра спектрального наклона Ptilt или их вариантов зависят от оборудования записи речевого сигнала, уровня фонового шума и/или громкоговорителей. Эти зависимости, которые трудно заранее определить, возможно, приводят к недостоверному обнаружению невокализованной/вокализованной речи.

[0048] Варианты осуществления настоящего изобретения описывают усовершенствованное обнаружение невокализованной/вокализованной речи, при котором используются “относительные” значения параметра периодичности Pvoicing и параметра спектрального наклона Ptilt или их вариантов вместо “абсолютных” значений. “Относительные” значения гораздо меньше, чем “абсолютные” значения, зависят от оборудования записи речевого сигнала, уровня фонового шума и/или громкоговорителей, что приводит к более достоверному обнаружению невокализованной/вокализованной речи.

[0049] Например, комбинированный параметр отсутствия вокализации можно задать согласно нижеприведенному уравнению (5).

Точки в конце уравнения (5) указывают, что можно добавить другие параметры. При увеличении “абсолютного” значения , он, вероятно, является невокализованным речевым сигналом. комбинированный параметр вокализации можно описать согласно нижеприведенному уравнению (6).

Точки в конце уравнения (6) аналогично указывают, что можно добавить другие параметры. При увеличении “абсолютного” значения , он, вероятно, является вокализованным речевым сигналом. До задания “относительных” значений или , сильно сглаженный параметр или задается. Например, параметр для текущего кадра можно сглаживать из предыдущего кадра, как описано неравенством, приведенным ниже в уравнении (7).

в уравнении (7), - сильно сглаженное значение .

[0050] Аналогично, сглаженный комбинированный параметр вокализации можно определить с использованием неравенства, приведенного ниже уравнении (8).

Здесь, в уравнении (8), - сильно сглаженное значение .

[0051] Статистическое поведение вокализованной речи отличается от статистического поведения невокализованной речи, и, таким образом в различных вариантах осуществления, можно находить параметры, удовлетворяющие вышеприведенному неравенству (например, 0.9, 0.99, 7/8, 255/256), и дополнительно уточнять их, при необходимости, на основании экспериментов.

[0052] “Относительные” значения или можно задавать согласно нижеприведенным уравнениям (9) и (10).

[0053] Нижеприведенное неравенство является иллюстративным вариантом осуществления применения обнаружения невокализованной речи. В этом иллюстративном варианте осуществления, установление флага Unvoiced_flag равным истина указывает, что речевой сигнал является невокализованной речью, тогда как установление флага Unvoiced_flag равным ложь указывает, что речевой сигнал не является невокализованной речью.

[0054] Нижеприведенное неравенство является альтернативным иллюстративным вариантом осуществления применения обнаружение вокализованной речи. В этом иллюстративном варианте осуществления, установление Voiced_flag равным истина указывает, что речевой сигнал является вокализованной речью, тогда как установление Voiced_flag равным ложь указывает, что речевой сигнал не является вокализованной речью.

[0055] После идентификации принадлежности речевого сигнала к вокализованному классы, речевой сигнал можно кодировать согласно подходу кодирования во временной области, например CELP. Варианты осуществления настоящего изобретения также можно применять для переклассификации невокализованного сигнала в вокализованный сигнал до кодирования.

[0056] В различных вариантах осуществления, вышеописанный усовершенствованный алгоритм обнаружение невокализованной/вокализованной речи может использоваться для улучшения AMR-WB-BWE и NR.

[0057] Фиг. 3 иллюстрирует операции, осуществляемые в ходе кодирования исходной речи с использованием традиционного кодера CELP, реализующего вариант осуществления настоящего изобретения.

[0058] Фиг. 3 иллюстрирует традиционный первоначальный кодер CELP, где взвешенная ошибка 109 между синтезированной речью 102 и исходной речью 101 минимизируется часто с использованием подхода анализа через синтез, и это означает, что кодирование (анализ) осуществляется путем перцепционной оптимизации декодированного (синтезированного) сигнала с обратной связью.

[0059] Базовый принцип, который используют все речевые кодеры, состоит в том, что речевые сигналы являются сильно коррелирующими формами волны. В порядке иллюстрации, речь можно представить с использованием авторегрессионной (AR) модели согласно нижеприведенному уравнению (11).

[0060] В уравнении (11), каждая выборка представлена в виде линейной комбинации предыдущих L выборок плюс белый шум. Весовые коэффициенты a1, a2,... aL называются коэффициентами линейного прогнозирования (LPC). Для каждого кадра, весовые коэффициенты a1, a2,... aL, выбираются таким образом, чтобы спектр {X1, X2, ..., XN}, генерируемый с использованием вышеописанной модели, был максимально близок к спектру входного речевого кадра.

[0061] Альтернативно, речевые сигналы также могут быть представлены комбинацией модели гармоник и модели шума. Гармоническая часть модели, по существу, является представлением периодической компоненты сигнала в виде ряда Фурье. В общем случае, для вокализованных сигналов, гармонико-шумовая модель речи состоит из смеси гармоник и шума. Соотношение гармоник и шума в вокализованной речи зависит от ряда факторов, включающих в себя характеристики говорящего (например, до какой степени голос говорящего является нормальным или хриплым); характер речевого сегмента (например, до какой степени речевой сегмент является периодическим) и от частоты. Более высокие частоты вокализованной речи имеют более высокое содержание шумоподобных компонентов.

[0062] Модель линейного прогнозирования и модель гармоник/шума являются двумя основными способами моделирования и кодирования речевых сигналов. Модель линейного прогнозирования особенно полезна при моделировании спектральной огибающей речи, тогда как модель гармоник/шума полезна при моделировании тонкой структуры речи. Два способа можно комбинировать, чтобы извлечь преимущество их относительных сил.

[0063] Как указано выше, до кодирования CELP, входной сигнал микрофона телефонной трубки фильтруется и дискретизируется, например, на скорости 8000 выборок в секунду. Затем каждая выборка квантуется, например, 13 битами для каждой выборки. Дискретизированная речь сегментируется на сегменты или кадры 20 мс (например, в этом случае 160 выборок).

[0064] Речевой сигнал анализируется, и его модель LP, сигналы возбуждения и основной тон извлекаются. Модель LP представляет спектральную огибающую речи. Он преобразуется в набор коэффициентов линейных спектральных частот (LSF), который является альтернативным представлением параметров линейного прогнозирования, поскольку коэффициенты LSF обладают хорошие свойства квантования. Коэффициенты LSF можно подвергать скалярному квантованию или, более эффективно, векторному квантованию с использованием ранее обученных кодовых книг векторов LSF.

[0065] Кодовое возбуждение включает в себя кодовую книгу, содержащую кодовые векторы, все компоненты которых независимо выбираются таким образом, что каждый кодовый вектор может иметь приблизительно ‘белый’ спектр. Для каждого подкадра входной речи, каждый из кодовых векторов фильтруется посредством фильтра 103 краткосрочного линейного прогнозирования и фильтра 105 долгосрочного прогнозирования, и выходной сигнал сравнивается с речевыми выборками. В каждом подкадре, кодовый вектор, выход которого наилучшим образом совпадает с входной речью (минимизированная ошибка), выбирается для представления этого подкадра.

[0066] Кодированное возбуждение 108 обычно содержит импульсоподобный сигнал или шумоподобный сигнал, которые математически построены или сохранены в кодовой книге. Кодовая книга доступна как кодеру, так и принимающему декодеру. Кодированное возбуждение 108, которое может быть стохастической или фиксированной кодовой книгой, может быть словарем векторного квантования, который (неявно или явно) зашит в кодек. Такая фиксированная кодовая книга может быть алгебраическим линейным прогнозированием с кодовым возбуждением или храниться явно.

[0067] Кодовый вектор из кодовой книги масштабируется надлежащим коэффициентом усиления, чтобы энергия была равна энергии входной речи. Соответственно, выходной сигнал кодированного возбуждения 108 масштабируется коэффициентом усиления Gc 107 до прохождения через линейные фильтры.

[0068] Фильтр 103 краткосрочного линейного прогнозирования формирует ‘белый’ спектр кодового вектора, напоминающий спектр входной речи. Эквивалентно, во временной области, фильтр 103 краткосрочного линейного прогнозирования включает краткосрочные корреляции (корреляцию с предыдущими выборками) в белой последовательности. Фильтр, который формирует возбуждение, имеет модель с одними полюсами в форме 1/A(z) (фильтр 103 краткосрочного линейного прогнозирования), где A(z) называется прогнозирующим фильтром и может быть получена с использованием линейного прогнозирования (например, алгоритма Левинсона-Дурбина). В одном или более вариантах осуществления, может использоваться фильтр с одними полюсами, поскольку он является хорошим представлением человеческого речевого тракта и поскольку его легко вычислять.

[0069] Фильтр 103 краткосрочного линейного прогнозирования получается путем анализа исходного сигнала 101 и представляется набором коэффициентов:

[0070] Как описано ранее, области вокализованной речи демонстрируют долгосрочную периодичность. Этот период, известный как основной тон, вносится в синтезированный спектр фильтром основного тона 1/(B(z)). Выходной сигнал фильтра 105 долгосрочного прогнозирования зависит от основного тона и коэффициента усиления основного тона. В одном или более вариантах осуществления, основной тон можно оценивать на основании исходного сигнала, остаточного сигнала или взвешенного исходного сигнала. В одном варианте осуществления, функцию долгосрочного прогнозирования (B(z)) можно выразить с использованием уравнения (13) следующим образом.

[0071] Взвешивающий фильтр 110 связан с вышеупомянутым фильтром краткосрочного прогнозирования. Один из типичных взвешивающих фильтров можно представить, как описано в уравнении (14).

[0072] В другом варианте осуществления, взвешивающий фильтр W(z) можно вывести из фильтра LPC с использованием расширения полосы как показано в одном варианте осуществления в нижеследующем уравнении (15).

В уравнении (15), γ1>γ2, которые являются коэффициентами, с которыми полюсы перемещаются к началу отсчета.

[0073] Соответственно, для каждого кадра речи, LPC и основной тон вычисляются, и фильтры обновляются. Для каждого подкадра речи, кодовый вектор, который формирует ‘наилучший’ фильтрованный выходной сигнал, выбирается для представления подкадра. Соответствующее квантованное значение коэффициента усиления подлежит передаче на декодер для надлежащего декодирования. LPC и значения основного тона также подлежат квантованию и отправке в каждом кадре для реконструкции фильтров на декодере. Соответственно, индекс кодированного возбуждения, квантованный индекс коэффициента усиления, квантованный индекс параметра долгосрочного прогнозирования и квантованный индекс параметра краткосрочного прогнозирования передаются на декодер.

[0074] Фиг. 4 иллюстрирует операции, осуществляемые в ходе декодирования исходной речи с использованием декодера CELP в соответствии с вариантом осуществления настоящего изобретения.

[0075] Речевой сигнал реконструируется на декодере путем пропускания принятых кодовых векторов через соответствующие фильтры. В результате, каждый блок, за исключением последующей обработки, имеет такое же определение, как описано в кодере, показанном на фиг. 3.

[0076] Кодированный битовый поток CELP принимается и распаковывается 80 на принимающем устройстве. Для каждого принятого подкадра, принятый индекс кодированного возбуждения, квантованный индекс коэффициента усиления, квантованный индекс параметра долгосрочного прогнозирования и квантованный индекс параметра краткосрочного прогнозирования, используются для нахождения соответствующих параметров с использованием соответствующих декодеров, например, декодера 81 коэффициента усиления, декодера 82 с долгосрочным прогнозир