Модифицированный интеллектуальный контроллер с адаптивным критиком

Иллюстрации

Показать всеИзобретение относится к интеллектуальному контроллеру с адаптивным критиком. Технический результат заключается в повышении адаптационных свойств системы управления на базе интеллектуального контроллера и повышении его быстродействия. Система содержит связанные между собой объект управления, блок критика, решающую нейронную сеть, блок действий, блок расчета подкрепления, блок расчета временной разности, блок выбора действия, блок отбора действий, блок обучения критика и блок занесения действий. 1 ил.

Реферат

Изобретение относится к интеллектуальным контроллерам, использующим принцип обучения с подкреплением, нечеткую логику, и может использоваться для управления сложными системами в недетерминированной среде.

Известен интеллектуальный контроллер на основе сетей адаптивных критиков, например патент США: МПК G06F 15/18 5448681. Данное устройство состоит из объекта управления, сети критика и управляющей нейронной сети. Выход объекта управления связан с первым входом сети критики и первым входом управляющей нейронной сети, выход управляющей нейронной сети связан с входом объекта управления и вторым входом сети критики, выход сети критики связан со вторым входом управляющей нейронной сети.

Принцип работы устройства по патенту МПК G06F 15/18 5448681 следующий: объект управления выдает сигнал о своем состоянии, сеть критики вычисляет подкрепление для текущей временной итерации и состояния объекта, управляющая нейронная сеть вычисляет управляющее воздействие с учетом подкрепления.

Общий недостаток устройств на основе сетей адаптивных критиков состоит в том, что этот алгоритм не является обобщенным и достаточным для построения универсальной адаптивной системы управления объектом, действующим в недетерминированной среде, чтобы убедиться в этом, достаточно взглянуть на количество методов реализации и структур (DHP, HDP, ВАС, GDHP, FACL, GIFACL и другие). К недостаткам можно отнести, так как система должна управляться в режиме реального времени, большее количество вычислений. Также к недостаткам можно отнести то, что система управления, построенная на базе адаптивного критика, не может радикально менять свое поведение и вырабатывать новые реакции при абсолютно новых, неизвестных данных о состоянии окружающей среды и объекта управления (D. Prokhorov, D. Wanch. Adaptive critic designs. IEEE transactions on Neural Networks, September 1997, pp.997-1007).

Наиболее близким техническим решением является патент РФ МПК G06F 15/00 №2450336 «Модифицированный интеллектуальный контроллер с адаптивным критиком». Контроллер по данному патенту состоит из нескольких структурных компонент: объекта управления, блока действий, решающей нейронной сети, блока критика, блока расчета временной разности, блока расчета подкрепления, блока выбора действия. При этом объект управления связан по выходам состояния и действия с блоком действий, блоком прогнозирования параметра, блоком расчета временной разности и блоком расчета подкрепления. Выход блока действий связан со вторым входом блока критика, выход блока прогнозирования параметра связан с первым входом блока критика. Выход блока критика связан с входом блока выбора действия и входом блока расчета временной разности. Блок расчета временной разности соединен с входами и выходом критика. Блок расчета подкрепления соединен с блоком расчета временной разности. Выходы блока выбора действия соединены с входами блока действий и объектом управления.

Принцип работы устройства по патенту РФ МПК G06F 15/00 №2450336 следующий: объект управления выдает сигналы состояния и действия, по которым блок действий выбирает возможные действия в данной ситуации и подает их на блок критика параллельно с прогнозным значением рабочего параметра, который рассчитывает блок прогнозирования параметра. Критик, получая данные, последовательно оценивает последствия возможных действий и выдает их на блок выбора действия, который с помощью «жадного» - правила выбирает действие и подает его на исполнение в объект управления. Параллельно этому процессу, блок расчета подкрепления рассчитывает полученное подкрепление и подает его на блок расчета временной разности, который рассчитывает ошибку временной разности и если ошибка существенная, то блок расчета временной разности останавливает работу критика и переобучает его на новых данных.

Недостатками данного контроллера являются: недостаточные адаптационные свойства, сложность реализации блока критика и его обучения, ограниченные возможности работы блока выбора действий.

Задача - разработка модифицированного интеллектуального контроллера с адаптивным критиком.

Техническим результатом предлагаемого устройства является повышение адаптационных свойств системы управления на базе интеллектуального контроллера, повышение его скоростных характеристик и упрощение конечной реализации для разработчика.

Технический результат достигается тем, что в модифицированном интеллектуальном контроллере с адаптивным критиком, содержащем объект управления, блок критика, решающую нейронную сеть, блок действий, блок расчета подкрепления, блок расчета временной разности, блок выбора действия, первый и второй выходы объекта управления связаны с первым и вторым входами решающей нейронной сети, первым и вторым входами блока расчета временной разности, первым и вторым входами блока расчета подкрепления, выход решающей нейронной сети соединен с первым входом блока критика, выход блока критика связан с входом блока выбора действия, выход блока расчета подкрепления связан с третьим входом блока расчета временной разности, выход блока выбора действия соединен с входом объекта управления, введены блок отбора действий, блок обучения критика и блок занесения действий, при этом первый и второй выходы объекта управления также соединены с первым и вторым входами блока отбора действий, первый выход блока отбора действий соединен с первым входом блока действий, второй выход блока отбора действий соединен со вторым входом блока критика, третий выход блока отбора действий соединен с третьим входом решающей нейронной сети, четвертый выход блока отбора действий соединен со вторым входом блока выбора действия, выход блока действий соединен с третьим входом блока отбора действий, выход блока расчета подкрепления соединен также со вторым входом блока занесения действий, выход блока расчета временной разности соединен с первым входом блока обучения критика, первый и второй выходы блока обучения критика соединены соответственно с первым и вторым входами блока критика, третий выход блока обучения критика соединен с четвертым входом блока расчета временной разности, выход блока критика также соединен со вторым входом блока обучения критика, выход блока выбора действия также соединен с первым входом блока занесения действий, выход блока занесения действий соединен со вторым входом блока действий.

Задача повышения адаптационных свойств достигается за счет выделения процесса обучения нейронной сети блока критика в отдельной компоненте - блоке обучения критика. Другим важным моментом является то, что работа с блоком действий строится по новому принципу с использованием двух новых блоков - блока отбора действий и блоком занесения действий. Скоростные характеристики работы системы повышаются за счет блока отбора действий, который отсекает возможные действия не подходящие по минимальному заданному подкреплению. Упрощение реализации для разработчика заключается в декомпозиции блока действий на несколько блоков, а также в выделении процесса обучения нейронной сети блока критика в отдельном блоке.

Таким образом, совокупность существенных признаков, изложенных в формуле изобретения, позволяет достигнуть желаемого результата.

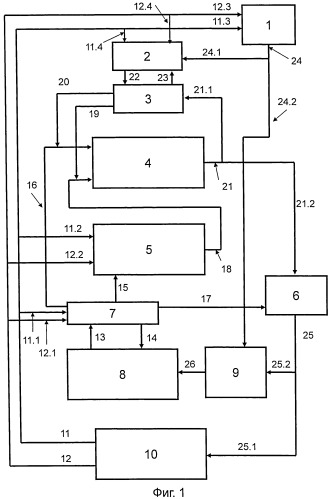

На фиг.1 изображена схема модифицированного интеллектуального контроллера с адаптивным критиком.

Система состоит из нескольких структурных компонент: блока расчета подкрепления 1, блока расчета временной разности 2, блока обучения критика 3, блока критика 4, решающей нейронной сети 5, блока выбора действия 6, блока отбора действий 7, блока действий 8, блока занесения действий 9, объекта управления 10.

Также в системе присутствуют следующие связи - от объекта управления идет сигнал состояния объекта 11, который соединен с входом блока отбора действий 11.1, решающей нейронной сети 11.2, блоком расчета подкрепления 11.3 и боком расчета временной разности 11.4. Также от объекта управления идет сигнал состояния внешней среды 12, который соединен с входами блока отбора действий 12.1, решающей нейронной сети 12.2, блоком расчета подкрепления 12.3 и блоком расчета временной разности 12.4. Выход блока действий соединен с блоком отбора действий по сигналу 13. От блока отбора действий идут сигналы на блок действий 14, решающую нейронную сеть 15, блока критика 16 и блок выбора действия 17. От решающей нейронной сети идет сигнал 18 на вход блока критика. Выходы блока обучения критика связаны с входами блока критика по сигналам 19 и 20, а выход блока критика 21 соединен с блоком обучения критика 21.1 и блоком выбора действия 21.2. От блока расчета временной разности идет сигнал 22 на блок обучения критика, также есть обратная связь от блока обучения критика к блоку расчета временной разности 23. Выход 24 блока расчета подкрепления соединен с входами: блока расчета временной разности 24.1 и блоком занесения действий 24.2. Выход 25 блока выбора действия соединен с входами объекта управления 25.1 и блока занесения действий 25.2. От блока занесения действий идет сигнал 26 на блок действий.

Блок расчета подкрепления 1 предназначен для расчета подкрепления r(t). Формула расчета подкрепления задается разработчиком.

Блок расчета временной разности 2 предназначен для расчета временной разности по формуле

δ(t)=r(t)+γ·V(t)-V(t-1),

где γ∈(0;1] - коэффициент забывания.

Блок обучения критика 3 предназначен для обучения/переобучения нейронной сети блока критика.

Блок критика 4 предназначен для расчета прогнозного значения качества ситуации V(t) последующей при выборе определенного действия. Для расчета качества ситуации используется послойно - полносвязная нейронная сеть прямого распространения сигнала (многослойный персептрон).

Решающая нейронная сеть 5 предназначена для прогнозирования следующего значения рабочего параметра системы (или нескольких параметров). Под рабочим параметром понимается тот параметр системы, оценивая который, система может определить, как она работает, либо это параметр, который служит ориентиром для работы системы (рабочих параметров может быть несколько).

Блок выбора действия 6 предназначен для выбора конкретного действия из всех возможных в данной ситуации. При выборе используется так называемое «ε - жадное правило» (Sutton R., Barto A. Reinforcement Learning: An Introducion. - Cambridge: MIT Press, 1998), которое можно записать как: «с вероятностью (1-е) выбирается то действие, которому соответствует максимальное значение качества ситуации , при этом 0<ε<<1».

Блок отбора действий 7 предназначен для отбора всех возможных действий в данной ситуации с учетом минимального накопленного подкрепления для возможного действия.

Блок действий 8 предназначен для хранения таблицы возможных действий во всех возможных ситуациях и накопленного подкрепления при совершении определенного действия в определенной ситуации.

Блок занесения действий 9 предназначен для внесения корректировок в блок действия 8. Данный блок обновляет значение накопленного подкрепления в ячейке выбранного действия на предыдущей итерации после отработки действия объектом управления.

Заявленное устройство работает следующим образом. Объект управления 10 выполняет действие и на выходах выдает сигналы состояния объекта 11 и внешней среды 12, которые поступают в блок отбора действий 7 по связям 11.1 и 12.1, по 11.2 и 12.2 в решающую нейронную сеть 5, по 11.3 и 12.3 в блок расчета подкрепления 1 и по 11.4 и 12.4 в блок расчета временной разности 2. При поступлении новых данных о состоянии объекта и внешней среды, блок отбора действий 7 запрашивает по связи 14 у блока действий 8 о возможных действиях в данной ситуации. При этом разработчиком при старте системы задается то минимальное значение совокупного полученного подкрепления, начиная с которого отбираются возможные действия в данной ситуации. Также задается количество итераций управления, при которых накапливается история полученного подкрепления в различных ситуациях при различных выполненных действиях (т.н. «этап исследования окружающей среды»). Получив обратно возможные действия в данной ситуации по связи 13, блок отбора действий 7 синхронно с блоком прогнозирования параметра 5 начинает подавать возможные действия на блок критика 4 по сигналу 16. Синхронизация решающей нейронной сети 5 и блока отбора действий 7 происходит по сигналу 15.

Решающая нейронная сеть 5, получив текущие значения состояния объекта управления 11.2 и внешней среды 12.2, вычисляет прогнозное значение рабочего параметра на следующую временную итерацию и подает вычисленное значение 18 на блок критика 4 совместно с сигналом 16 от блока отбора действий 7.

Блок критика 4, последовательно получая пары значений {возможное_действие; прогноз_рабочего_параметра}, прогнозирует возможное будущее подкрепление 21 при выполнении данного возможного действия.

Блок расчета подкрепления 1, получая значения текущего состояния внешней среды 12.3 и объекта управления 11.3, вычисляет по заданной формуле значение полученного подкрепления за последнюю отработанную итерацию управления. Полученное значение 24.1 рассчитанного подкрепления подается в блок расчета временной разности 2, который рассчитывает значение временной разности и формирует наборы {входы; выходы} для обучения нейронной сети блока критика 4. В случае, если ошибка временной разности велика, то есть выше заданного разработчиком предела, то блок расчета временной 2 запускает процесс переобучения нейронной сети блока критика 4, посылая сигнал 22 на блок обучения критика 3. Блок обучения критика 3 получает сигнал о старте переобучения нейронной сети блока критика 4 и начинает процесс переобучения нейросети блока критика. При этом активируются связи на входы 19 и 20 нейронной сети блока критика 4, тем самым блокируются поступления данных от блока отбора действий 7 и блока прогнозирования параметра 5. Блок обучения критика 3, пользуясь алгоритмом обратного распространения ошибки (см. подробнее Rumelhart D.E., Hinton G.E., Williams R.J., "Learning representations by back-propagating errors," Nature, vol.323, pp.533-536, 1986) обучает нейронную сеть блока критика 4. При этом примеры выбираются случайным образом, запрос на новый пример идет по связи 23, соответственно возврат номера примера для обучения идет по связи 22. Входы выбранного примера подаются на входы 19 и 20 нейронной сети блока критика 4, затем снимается значение выхода 21.1 нейронной сети блока критика 4 и сравнивается с выходом обучающего примера. Если ошибка выше заданной разработчиком, то формируется следующий обучающий пример и т.д.

После того как нейронная сеть блока критика 4 обучилась, входы 19 и 20 на блок критика 4 деактивируются и на него начинают поступать сигналы 16 и 18 от блока отбора действий 7 и решающей нейронной сети 5 и блок критика 4 начинает работать в обычном режиме, то есть рассчитывает возможное подкрепление для каждого возможного действия. Рассчитанное подкрепление для каждого возможного действия поступает на блок выбора действия 6, который, пользуясь т.н. «жадным правилом», выбирает действие и подает его на объект управления 10 по сигналу 25.1 и блок занесения действий 9 по сигналу 25.2. Блок занесения действий 9 обновляет по сигналу 26 значение определенной ячейки в блоке действий 8. То есть, если на (i-1) итерации в ситуации Si-1 управления было выбрано К-е действие, оно было отработано объектом управления и было получено подкрепление ri-1 (возможно отрицательное), которое и заносится в ячейку К-го действия в Si-1 ситуации. Таким образом, блок занесения действий 9 задерживает на такт выбранное действие 25.2 и обновляет совокупное накопленное подкрепление данного действия в соответствующей ситуации после того, как был получен результат работы в виде подкрепления.

Принцип работы блока действий 8 следующий. Блок действий 8 представляет собой четверки значений, которые можно реализовать в виде матрицы. Четверка значений следующая {Состояние внешней среды, Состояние объекта управления. Накопленный коэффициент эффективности, Возможное действие}. Соответственно блок отбора действий 7 выбирает те действия, которые проходят по критерию минимально заданного накопленного подкрепления, а блок занесения действий 9 обновляет значение накопленного коэффициента эффективности для выбранного действия в определенном состоянии внешней среды и объекта управления.

Модифицированный интеллектуальный контроллер с адаптивным критиком, содержащий объект управления, блок критика, решающую нейронную сеть, блок действий, блок расчета подкрепления, блок расчета временной разности, блок выбора действия, первый и второй выходы объекта управления связаны с первым и вторым входами решающей нейронной сети, первым и вторым входами блока расчета временной разности, первым и вторым входами блока расчета подкрепления, выход решающей нейронной сети соединен с первым входом блока критика, выход блока критика связан с входом блока выбора действия, выход блока расчета подкрепления связан с третьим входом блока расчета временной разности, выход блока выбора действия соединен с входом объекта управления, отличающийся тем, что в него введены блок отбора действий, блок обучения критика и блок занесения действий, при этом первый и второй выходы объекта управления также соединены с первым и вторым входами блока отбора действий, первый выход блока отбора действий соединен с первым входом блока действий, второй выход блока отбора действий соединен со вторым входом блока критика, третий выход блока отбора действий соединен с третьим входом решающей нейронной сети, четвертый выход блока отбора действий соединен со вторым входом блока выбора действия, выход блока действий соединен с третьим входом блока отбора действий, выход блока расчета подкрепления соединен также со вторым входом блока занесения действий, выход блока расчета временной разности соединен с первым входом блока обучения критика, первый и второй выходы блока обучения критика соединены соответственно с первым и вторым входами блока критика, третий выход блока обучения критика соединен с четвертым входом блока расчета временной разности, выход блока критика также соединен со вторым входом блока обучения критика, выход блока выбора действия также соединен с первым входом блока занесения действий, выход блока занесения действий соединен со вторым входом блока действий.